IN086 – Temu Pengetahuan

advertisement

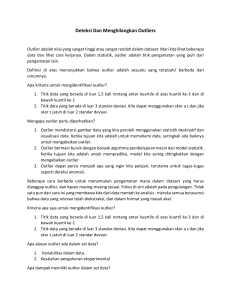

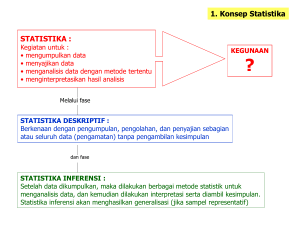

IN086 – Temu Pengetahuan 5. Data Preprocessing 1 Mengapa Data Preprocessing ? • Data di dunia nyata itu kotor • Tidak lengkap: kekurangan nilai atribut, kekurangan beberapa atribut yang dibutuhkan, atau hanya terdiri dari data agregat • Contoh: pekerjaan=“” • Berisik / tidak bersih: terdapat error atau outlier • Tidak konsisten: terdapat perbedaan dalam kode dan nama – nama • Contoh: gaji=“-1000000” Contoh: Usia=“42” UlangTahun=“03/07/1997” Contoh: Rating dulu “1,2,3” Rating sekarang “A,B,C” • Contoh: Perbedaan antara catatan – catatan yang duplikat • • 2 Mengapa Data Kotor? • Data yang tidak lengkap mungkin berasal dari Data bernilai “Not Applicable” saat direkam Pertimbangan yang berbeda saat data direkam dan saat data dianalisa • Masalah – masalah perangkat keras / perangkat lunak • • • Data yang berisik (noisy / data yang tidak benar) mungkin berasal dari • • • • Data yang tidak konsisten mungkin berasal dari • • • Instrumen yang mengumpulkan data yang salah Kesalahan manusia atau komputer saat entri data Kesalahan saat transmisi data Sumber – sumber data yang berbeda Pelanggaran ketergantungan fungsinal (contoh: memodifikasi data yang terhubung) Data duplikat juga perlu dibersihkan 3 Mengapa Data Preprocessing Penting? • No quality data, no quality mining results! • Keputusan berkualitas harus berasal dari data yang berkualitas • • • Contoh: data duplikat atau hilang dapat menyebabkan statistik yang salah atau menyesatkan Data Warehouse membutuhkan integrasi yang konsisten dari data yang berkualitas Ekstraksi data, pembersihan, dan transformasi merupakan pekerjaan terbesar dari membangun sebuah Data Warehouse 4 Tugas – Tugas Utama dalam Data Preprocessing • Pembersihan Data • • Integrasi Data • • Normalisasi dan agregasi Reduksi Data • • Integrasi dari basis data, data cube, atau berkas – berkas yang beragam Transformasi Data • • Mengisi nilai – nilai yang hilang, menghaluskan data yang berisik, mengidentifikasi outlier, dan menyelesaikan ketidakkonsistenan. Mendapatkan representasi yang lebih sedikit dalam volume tetapi menghasilkan hasil analisis yang sama atau mirip Dikretisasi Data • Bagian dari reduksi data tapi dengan kepentingan yang tertentu, khususnya untuk data numerik 5 Bentuk – Bentuk dari Data Preprocessing 6 Deskripsi Data 7 Karakteristik dari Mining Data Deskriptif • Motivasi • Untuk lebih memahami data: tendensi sentral, variasi, sebaran • Karakteristik Dispersi Data • median, max, min, quantiles, outliers, variance, dll. • Dimensi numerik yang berhubungan dengan interval yang disortir • Dispersi Data: dianalisa dengan presisi yang bergranularitas beragam • Analisis boxplot atau quantile untuk interval yang tersortir • Analisis Dispersi dari nilai – nilai terkomputasi • Melipat pengukuran dalam dimensi numerik • Analisis boxplot atau quantile untuk kubus yang ditransformasi 8 Mengukur Tendensi Sentral Mean (pengukuran aljabar) (sampel vs. populasi): • • Weighted arithmetic mean: • Trimmed mean: memangkas nilai extreme x 1 n n i 1 n x i 1 n N wi xi i 1 i • Nilai tengah dari nilai – nilai berjumlah ganjil, atau rata – rata nilai tengah untuk yang lainnya. • Diestimasikan dengan interpolasi (untuk data berkelompok) median L1 ( Mode • w Median: Sebuah nilai holistik • xi • Nilai yang muncul paling sering dalam data • Unimodal, bimodal, trimodal • Rumus empiris: n / 2 ( f )l f median mean mode 3 (mean median) 9 9 Data Simetris vs Skewed • )c Median, mean and mode dari data simetris, skewed positif dan skewed negatif 10 10 x Mengukur Sebaran Data • • Quartiles, outliers dan boxplots • Quartiles: Q1 (25th percentile), Q3 (75th percentile) • Inter-quartile range: IQR = Q3 – Q1 • Five number summary: min, Q1, M, Q3, max • Boxplot: akhir dari kotak adalah the quartiles, median ditandai, whiskers, dan mengeplot outlier satu persatu • Outlier: biasanya nilai lebih tinggi / rendah dari 1.5 x IQR Variance dan standard deviasi (sample: s, population: σ) • 1 n 1 n 2 xi 2 ( xi ) 2 N N i 1 i 1 Variance: (algebraic, scalable computation) s2 • 2 1 n 1 n 2 1 n 2 (xi x)2 [ xi ( xi ) ] n 1 i1 n 1 i1 n i1 Standard deviasi s (or σ) adalah akar kuadrat dari variance s2 (or σ2) DM-MA/S1IF/FTI/UKM/2010 11 Properti dari Kurva Distribusi Normal • Kurva distribusi normal • Dari μ–σ ke μ+σ: mengandung sekitar 68% seluruh pengukuran (μ: mean, σ: standard deviasi) • Dariμ–2σ to μ+2σ: mengandung sekitar 95% seluruh pengukuran • Dari μ–3σ to μ+3σ: mengandung sekitar 99.7% seluruh pengukuran DM-MA/S1IF/FTI/UKM/2010 12 12 Analisis Histogram • Tampilan grafis dari deskripsi kelas statistika dasar • Histogram frekuensi Sebuah metode grafika yang univariate • Terdiri dari sebuah set dari kotak – kotak yang merefleksikan jumlah atau frekuensi dari kelas – kelas yang ada dalam data • 10/1/2014 13 Plot tebar / Scatter plot • Menyediakan tampilan awal dari data yang bersifat bivariate untuk melihat klaster dari poin, outlier, dll • Setiap pasang nilai diterjemahkan sebagai sepasang koordinat dan diplot sebagai poin dalam latar DM-MA/S1IF/FTI/UKM/2010 10/1/2014 14 Data preprocessing 15 Pembersihan Data • Arti penting Pembersihan data merupakan salah satu dari tiga permasalahan besar dalam Data Warehousing – Ralph Kimball • Pembersihan data adalah permasalahan nomor satu dari Data Warehousing – Survey DCI • • Tugas – tugas Pembersihan Data Mengisi nilai – nilai yang hilang • Mengidentifikasi outlier dan menghaluskan data yang berisik • Mengoreksi data yang tidak konsisten • Menyelesaikan duplikasi yang disebabkan karena integrasi data • DM-MA/S1IF/FTI/UKM/2010 16 Data yang Hilang • Data tidak selalu harus tersedia • • Hilangnya data mungkin disebabkan oleh • • • • • • Contoh: banyak tuples (pasangan data) yang tidak memiliki data yang terekam untuk beberapa atributnya, seperti penghasilan konsumen dalam data sales Kerusakan instrumen Ketidakkonsistenan dengan rekaman data yang lain yang akhrinya dihapus Data tidak dimasukkan karena kesalahpahaman Beberapa data tidak dianggap penting waktu di entri Tidak ada daftar historis atau perubahan dari data Data yang hilang mungkin perlu diperkirakan nilainya. DM-MA/S1IF/FTI/UKM/2010 17 Bagaimana Menangani Missing Data? • Mengabaikan tuple: biasanya dilakukan ketika label kelas hilang (diasumsikan untuk tugas klasifikasi) – tidak efektif apabila prosentase dari nilai yang hilang di setiap atribut bervariasi secara besar • Mengisi nilai yang hilang secara manual: memakan waktu + memungkinkan? • Mengisi secara otomatis dengan • Nilai konstan global, contoh: “tidak diketahui”, sebuah kelas yang baru • Nilai tengah atribut • Nilai tengah atribut untuk sampel yang memiliki kelas yang sama (lebih pintar) • Nilai paling mungkin: berdasarkan inferensi seperti rumus Bayesian atau pohon keputusan 18 Data Berisik / Noisy • Noise: error random atau variance dari sebuah variabel yang diukur • Nilai atribut yang tidak benar mungkin disebabkan oleh • • • • • • Instrumen pengumpul data yang salah Masalah data entri Masalah transmisi data Limitasi teknologi Ketidakkonsistenan dalam kesepakatan penamaan Kesalahan – kesalahan lain yang membutuhkan pembersihan data • • • Data duplikat Data tidak lengkap Data tidak konsisten DM-MA/S1IF/FTI/UKM/2010 19 Bagaimana Menangani Noisy Data? • Binning Pertama menyortir data dan mempartisi menjadi bin – bin berfrekuensi sama • Kemudian dapat dilakukan smooth by bin means, smooth by bin median, smooth by bin boundaries, dll. • • Regresi • • Clustering • • Menghaluskan dengan memasangkan data dalam fungsi regresi Mendeteksi dan menghilangkan outlier Kombinasi inspeksi komputer dan manusia • Mendeteksi nilai – nilai yang dicurigai dan dicek oleh manusia (contoh menangani kemungkinan outlier) 20 Metode Diskretisasi Sederhana: Binning • Equal-width (distance) partitioning Membagi kisaran dalam N interval dengan ukuran yang sama: grid seragam • Jika A dan B adalah nilai terendah dan tertinggi dari atribut, lebar internval menjadi: W = (B – A) / N • Sangat simpel, tapi presentasi akan didominasi outlier • Data skewed tidak tertangani dengan baik • • Equal-depth (frequency) partitioning Membagi kisaran dalam N interval, setiap interval berisi sampel yang kira – kira sama jumlahnya • Skala data yang baik • Mengatur data kategoris mungkin agak sulit • 21 Metode Binning untuk Penghalusan Data Sortir data untuk harga (dalam dollars): 4, 8, 9, 15, 21, 21, 24, 25, 26, 28, 29, 34 * Partisi dalam equal-frequency (equi-depth) bins: - Bin 1: 4, 8, 9, 15 - Bin 2: 21, 21, 24, 25 - Bin 3: 26, 28, 29, 34 * Penghalusan dengan bin means: - Bin 1: 9, 9, 9, 9 - Bin 2: 23, 23, 23, 23 - Bin 3: 29, 29, 29, 29 * Penghalusan dengan bin boundaries: - Bin 1: 4, 4, 4, 15 - Bin 2: 21, 21, 25, 25 - Bin 3: 26, 26, 26, 34 22 Integrasi Data • Integrasi Data: • • Skema integrasi: contoh A.cust-id B.cust-# • • Mengintegrasikan meta data dari berbagai sumber Permasalahan identifikasi Entitas: • • Mengkombinasikan data dari sumber – sumber yang berbeda dalam sebuah penyimpanan yang koheren Mengidentifikasi entitas dunia nyata dari berbagai sumber, contoh Bill Clinton = William Clinton Mendeteksi dan menyelesaikan konflik nilai data • Untuk entitas dunia nyata yang sama, nilai atribut dari sumber berbeda mungkin bernilai berbeda • Alasan yang mungkin: representasi yang berbeda, skala yang berbeda, contoh unit metrik dan unit British 23 Menganani Kembaran Data dalam Integrasi Data • Data redundan (kembar) mungkin sering terjadi dalam integrasi dari berbagai basis data • Object identification: atribut atau obyek yang sama mungkin memiliki nama berbeda pada basis data yang berbeda • Derivable data: satu atribut mungkin sebuah atribut derivasi dari atribut tabel yang lainnya, contoh revenue tahunan • Atribut kembaran mungkin dapat dideteksi dengan melakukan analisis korelasi • Integrasi yang hati – hati dari data yang berasal dari berbagai sumber bisa mengurangi / menghidari kembaran atau ketidakkonsistenan dan meningkatkan kecepatan dan kualitas mining. 24 Transformasi Data • Penghalusan: menghilangkan noise dari data • Agregasi: merangkum, konstruksi kubus data • Generalisasi: konsep menyusuri hirarki • Normalisasi: diskala untuk masuk dalam kisaran yang kecil dan tertentu • • Normalisasi min – max • Normalisasi z-score • Normalisai dengan skala desimal Konstruksi atribut / fitur Atribut – atribut baru dibuat dari atribut yang sudah diberikan • 25 Strategi Reduksi Data • Mengapa Reduksi Data? • • • Reduksi Data • • Sebuah basis data / Data Warehouse dapat menyimpan data dalam terabita Data analisis yang kompleks / mining dapat memakan waktu yang sangat lama apabila dilakukan di set data yang lengkap Mendapatkan representasi data set yang dikurangi yang sangat lebih kecil dalam volume tapi dapat menghasilkan hasil analisis yang sama (atau hampir sama) Strategi Reduksi Data • • • • • Data cube aggregation: Dimensionality reduction — contoh menghilangkan atribut tidak penting Data Compression Numerosity reduction — contoh mengepaskan data dalam model Discretization dan concept hierarchy generation 26 Diskretisasi • • Tiga tipe atribut • Nominal – nilai dari set yang tidak berurut, contoh warna, profesi • Ordinal – nilai dari set yang berurut, contoh rangking militer dan akademis • Continuous – nilai riil, contoh nilai integer atau real Diskretisasi • Membagi kisaran dari nilai atribut continuous menjadi interval – interval • Beberapa algoritma klasifikasi hanya menerima atribut kategorikal • Mengurangi ukuran data dengan diskretisasi • Penyiapkan untuk analisa lanjutan 27 Diskretisasi dan Hirarki Konsep • • Diskretisasi • Mengurangi jumlah dari nilai – nilai untuk atribut yang continuous dengan membaginya dalam kisaran atribut dalam interval – interval • Label interval kemudian dipakai untuk mengganti nilai data aktual • Supervised dan unsupervised • Split (top – down) vs. Merge (bottom – up) • Diskretisasi dapat dilakukan secara rekursif pada sebuah atribut Formasi hirarki konsep • Secara rekursif mereduksi data dengan mengumpulkan dan mengganti konsep yang level rendah (seperti nilai numerik untuk umur) menjadi konsep yang tingkatannya lebih tinggi (seperti muda, dewasa, senior) 28