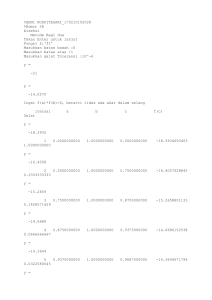

ANALISIS REGRESI LINEAR Johan Harlan Analisis Regresi Linear Penulis : Johan Harlan Cetakan Pertama, Agustus 2018 Disain cover : Joko Slameto Diterbitkan pertama kali oleh Gunadarma Jl. Margonda Raya No. 100, Pondokcina, Depok 16424 Telp. +62-21-78881112, 7863819 Faks. +62-21-7872829 e-mail : [email protected] Hak Cipta dilindungi undang-undang. Dilarang mengutip atau memperbanyak dalam bentuk apapun sebagian atau seluruh isi buku tanpa ijin tertulis dari penerbit. KATA PENGANTAR Buku Analisis Regresi Linear ini sebagian besar memuat materi pengajaran Statistika tingkat dasar dengan sedikit pengembangan untuk tingkat lanjut. Analisis regresi linear memiliki secara teoretis dasar matematik yang luas dan mendetil, terutama dengan menerapkan aljabar matriks, namun dalam pembahasan di sini penulis berusaha menghindari pembahasan yang bersifat matematis dengan lebih banyak membahas pemahaman praktis disertai contoh-contoh aplikatifnya. Sesuai dengan perkembangan Statistika pada era Teknologi Informasi ini yang semakin lama semakin banyak memanfaatkan program komputer statistik, antara lain sebagai dampak semakin bervariasinya teknik dan metode baru Statistika yang sangat sulit dan hampir tidak mungkin untuk diterapkan secara manual, praktis semua metode yang dibahas dalam buku ini disertakan contoh aplikasinya dengan menggunakan program Stata 15. Penulis sangat mengharapkan saran-saran yang berguna dari pembaca untuk memperbaiki kesalahan-kesalahan yang ada dalam isi buku ini serta meningkatkan kualitas pembahasannya. Jakarta, Agustus 2018 Penulis v DAFTAR ISI Kata Pengantar v Daftar Isi vi Bab 1 Bab 2 Bab 3 Bab 4 Diagram Tebar dan Garis Regresi 1 Diagram Tebar 1 Garis Regresi 2 Regresi Linear Sederhana 5 Regresi Linear Sederhana dengan Prediktor Kontinu 5 Regresi Linear Sederhana dengan Prediktor Indikator 10 Regresi Linear Ganda 13 Regresi Linear Ganda dengan Prediktor Kontinu 13 Regresi Linear Ganda dengan Prediktor Kategorik NonBiner 17 Regresi Linear Ganda dengan Interaksi 20 Asumsi-Asumsi pada Regresi Linear 27 Model Adekuat 27 Asumsi Linearitas 28 Asumsi Independensi dan Non-Otokorelasi 30 Asumsi Normalitas 32 Asumsi Homoskedastisitas 33 Asumsi Non-Multikolinearitas 34 vi Bab 5 Bab 6 Bab 7 Bab 8 Estimasi Koefisien Regresi dan Interpretasi Hasil 39 Metode Estimasi Koefisien Regresi 39 Tabel Analisis Variansi 40 Tabel Koefisien Regresi 43 Konfaunding dan Interaksi 49 Konfaunding 49 Interaksi 62 - Modifikasi Efek 62 - Interaksi Statistik 63 Konfaunding dan Interaksi 70 Diagnostika Regresi 73 Outliers dan Pengamatan Influensial 73 Leverage 75 Jarak Cook 76 DFBETA 77 Beberapa Penanganan Penyimpangan Asumsi 87 Estimasi Variansi Robust 88 Regresi Robust 91 Regresi Ridge 99 Kepustakaan 106 Lampiran 1 Pemodelan dan Seleksi Prediktor 108 Lampiran 2 Beberapa Grafik Galat 111 vii BAB 1 DIAGRAM TEBAR DAN GARIS REGRESI Diagram Tebar Diagram tebar (scatter scatter diagram diagram) adalah diagram dua dimensi untuk sampel pengamatan bivariat. Diagram iagram tebar merupakan alat bantu yang penting untuk menilai tipe hubungan antar 2 variabel kontinu. Gambar 1.1 Rerata suhu tahunan di suatu wilayah dan angka kematian karena kanker payudara 1 Contoh 1.1: Pada contoh ini akan diperlihatkan perintah Stata untuk menghasilkan diagram tebar dengan menggunakan file dataset auto_simp.dta. . use “D:\Analisis Regresi Linear Linear\Data\auto_simp.dta”, clear (1978 Automobile Data) . scatter mpg weight Garis Regresi Garis regresi adalah garis lurus di antara titik titik-titik pada diagram tebar yang secara terbaik menggambarkan hubungan linear antara kedua variabel pada diagram tebar tersebut. Garis ini sering pula disebut sebagai garis dengan kesesuaian terbaik (line line of best best-fit), yang memiliki jarak terdekat dengan seluruh titik-titik titik pada diagram tebar itu. Tanpa membahas cara perolehan garis regresi (akan dibah dibahas dalam bab-bab bab berikut), di bawah ini diperlihatkan beberapa contoh diagram tebar 2 beserta garis regresinya yang menggambarkan tipe hubungan antar kedua variabel pada diagram tersebut. Gambar 1.2 Atas kiri: Hubungan positif; Atas kanan: Hubungan negatif; Bawah: Tidak ada hubungan Ketiga tipe hubungan yang terlihat pada gambar 1.2 yaitu: a. Hubungan positif (kiri atas):: Pe Pertambahan nilai X (sumbu horizontal) umumnya disertai dengan pertambahan nilai Y (sumbu vertikal) b. Hubungan negatif:: Pertambahan nilai X (sumbu horizontal) umumnya disertai dengan pengurangan nilai Y (sumbu vertikal) c. Tidak ada hubungan:: Pertambahan nilai X (sumbu horizontal) tidak jelas memiliki efek terhadap nilai Y (sumbu vertikal). Contoh 1.2: Pada contoh ini, dengan menggunakan file dataset auto_simp.dta yang sama seperti pada contoh 1.1, akan diperlihatkan perintah Stata mula mulamula untuk memperoleh diagram tebar beserta garis regresinya dan kemudian hanya diagram garis regresinya. 3 . use “D:\Analisis Analisis Regresi Linear Linear\Data\auto_simp.dta”, clear (1978 Automobile Data) Garis regresi di antara titik--titik pada diagram tebar diperlihatkan sebagai berikut: . scatter mpg weight || lfit mpg weight Perintah twoway lfit menghasilkan hhanya garis regresi: . twoway lfit mpg weight 4 BAB 2 REGRESI LINEAR SEDERHANA Regresi linear (linear regression) adalah teknik yang digunakan untuk memperoleh model hubungan antara 1 variabel dependen dengan 1 atau lebih variabel independen. Jika hanya digunakan 1 variabel independen dalam model, maka teknik ini disebut sebagai regresi linear sederhana (simple linear regression), sedangkan jika yang digunakan adalah beberapa variabel independen, teknik ini disebut regresi linear ganda (multiple linear regression). Variabel dependen pada regresi linear disebut juga sebagai respons atau kriterion, sedangkan variabel independen dikenal pula sebagai prediktor atau regresor. Kovariat adalah variabel independen yang berkorelasi dengan prediktor lainnya, juga mempengaruhi respons. Kovariat umumnya tidak diminati hubungannya dengan respons dan hanya digunakan untuk pengendalian hubungan prediktor-respons dalam model. Respons pada regresi linear selalu berupa variabel kontinu, sedangkan prediktor dapat berupa variabel kontinu, indikator, ataupun karegorik yang disubstitusikan menjadi variabel indikator. Regresi Linear Sederhana dengan Prediktor Kontinu Model yang digunakan untuk regresi linear sederhana adalah: Yi = β 0 + β 1 X i + ε i Yi : Respons untuk subjek ke-i Xi : Prediktor untuk subjek ke-i εi Galat untuk subjek ke-i : ; 5 i = 1, 2, . . . , n ` β 0 dan β 1 merupakan parameter dalam populasi yang hendak diestimasi dalam fitting model. Pada fitting model dengan data sampel akan diperoleh persamaan garis regresi (gambar 2.1) 2.1): Yˆi = b 0 + b1 X i ; i = 1, 2, . . . , n b 0 dinamakan intersep (intercept) atau konstante, menyatakan jarak dari titik pangkal ke titik potong garis regresi dengan sumbu Y (sumbu vertikal),, merupakan penaksir untuk β 0 . b1 disebut juga sebagai kemiringan (slope) atau koefisien regresi, menyatakan kemiringan garis regresi yang diukur sebagai tangen sudut yang dibentuk oleh garis horizontal dengan garis regresi dalam arah positif (diukur berlawanan de dengan perputaran jarum jam), merupakan penaksir untuk β 1 . ei menyatakan galat untuk anggota sampel ke-i, sekaligus merupakan penaksir untuk ε i . Gambar 2.1 Garis regresi Perintah Stata untuk fitting model regresi linear sederhana adalah: regress var_dep var_indep indep [if] [in] [, options] var_dep : var_indep : Variabel dependen Variabel independen 6 Contoh 2.1: File dataset yang digunakan di sini adalah elemapi.dta, yang menyatakan kinerja akademik sejumlah sekolah di sebuah regio di Amerika Serikat. . use “ D:\Analisis Regresi Linear\Data\elemapi.dta”, clear . sum enroll api00 Variable | Obs Mean Std. Dev. Min Max ---------+-------------------------------------------------enroll | 400 483.465 226.4484 130 1570 api00 | 400 647.6225 142.249 369 940 enroll : api00 : Kinerja akademik sekolah pada tahun 2000 Jumlah siswa Selanjutnya dilakukan fitting model regresi linear sederhana. . regress api00 enroll Source | SS df MS ---------+---------------------------Model | 817326.293 1 817326.293 Residual | 7256345.70 398 18232.0244 ---------+---------------------------Total | 8073672.00 399 20234.7669 Number of obs F( 1, 398) Prob > F R-squared Adj R-squared Root MSE = = = = = = 400 44.83 0.0000 0.1012 0.0990 135.03 ---------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-------------------------------------------------------enroll | -.1998674 .0298512 -6.70 0.000 -.2585532 -.1411817 _cons | 744.2514 15.93308 46.71 0.000 712.9279 775.5749 ---------------------------------------------------------------7 Tampak estimasi intersep dan koefisien regresi, masing-masing sebesar 744.25 dan −0.20. Estimasi intersep menyatakan prediksi nilai respons, jika prediktor bernilai nol, walaupun hal ini tidak realistis di sini, yaitu jika enroll bernilai sama dengan nol (tidak ada calon siswa yang mendaftarkan diri), tidak mungkin kinerja akademik api00 bernilai 744.25. Perlu dijelaskan bahwa prediksi nilai respons hanya berlaku dalam rentang nilai-nilai prediktor dalam sampel, yaitu 130 s.d. 1,570. Estimasi koefisien regresi bernilai negatif sebesar −0.20 dan bermakna secara statistik dengan p = 0.00, menyatakan bahwa setiap pertambahan 1 siswa yang mendaftar akan menurunkan kinerja akademik sekolah sebesar −0.20 satuan. Model estimasi adalah: api00 = 744.25 – 0.20 enroll + e Contoh 2.2: File yang digunakan di sini merupakan penyederhanaan terhadap file auto.dta, yang sering digunakan pada berbagai contoh perintah Stata. Sesuai dengan topik pada bab ini, yang disisakan pada file auto_simp.dta hanya variabel mpg dan weight yang akan digunakan dalam model regresi linear sederhana di sini. . use “D:\Analisis Regresi Linear\Data\auto_simp.dta”, clear (1978 Automobile Data) Perintah berikut adalah untuk fitting model regresi linear sederhana: . regress mpg weight 8 Source | SS df MS ---------+--------------------------Model | 1591.9902 1 1591.9902 Residual | 851.469256 72 11.8259619 ---------+--------------------------Total | 2443.45946 73 33.4720474 Number of obs F(1, 72) Prob > F R-squared Adj R-squared Root MSE = = = = = = 74 134.62 0.0000 0.6515 0.6467 3.4389 -------------------------------------------------------------mpg | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-----------------------------------------------------weight | -.0060087 .0005179 -11.60 0.000 -.0070411 -.0049763 _cons | 39.44028 1.614003 24.44 0.000 36.22283 42.65774 -------------------------------------------------------------Model estimasi adalah: mpg = 39.44 – 0.01 weight + e Tampak bahwa nilai koefisien determinasi R 2 adalah 0.6515, menunjukkan bahwa 65% variasi respons mpg dapat “dijelaskan” oleh prediktor weight. Prediktor weight tampak bermakna dengan nilai p = 0.000. Untuk fitting model regresi yang melalui titik pangkal (tanpa intersep), perintahnya adalah: . regress, beta Source | SS df MS ---------+--------------------------Model | 1591.9902 1 1591.9902 Residual | 851.469256 72 11.8259619 ---------+--------------------------Total | 2443.45946 73 33.4720474 9 Number of obs F(1, 72) Prob > F R-squared Adj R-squared Root MSE = = = = = = 74 134.62 0.0000 0.6515 0.6467 3.4389 -------------------------------------------------------------mpg | Coef. Std. Err. t P>|t| Beta -------+-----------------------------------------------------weight | -.0060087 .0005179 -11.60 0.000 -.8071749 _cons | 39.44028 1.614003 24.44 0.000 . ------------------------------------------------------------Model estimasi untuk model tanpa intersep menjadi: mpg = −81 weight + e Regresi Linear Sederhana dengan Prediktor Indikator Model untuk regresi linear sederhana dengan prediktor indikator (variabel dummy) adalah: Yi = β 0 + β 1 X i + ε i Xi : ; X = {0, 1} Prediktor indikator (variabel dummy). Indikator adalah variabel kategorik biner yang hanya dapat bernilai 0 atau 1. Perhatikan bahwa indikator tidak diberikan nilai 1 atau 2. Variabel kategorik biner yang bernilai 1 dan 2 terlebih dahulu dikonversi menjadi indikator yang bernilai 0 atau 1 sebelum dilakukan fitting model. Contoh 2.3: . use “ D:\Analisis Regresi Linear\Data\elemapi.dta”, clear . tabulate yr_rnd 10 year round | school | Freq. Percent Cum. -----------+--------------------------------No | 308 77.00 77.00 Yes | 92 23.00 100.00 -----------+--------------------------------Total | 400 100.00 . tabulate yr_rnd, nolabel year round | school | Freq. Percent Cum. -----------+--------------------------------0 | 308 77.00 77.00 1 | 92 23.00 100.00 -----------+--------------------------------Total | 400 100.00 yr_rnd (year round school) adalah variabel indikator dengan nilai 0 atau 1. Selanjutnya akan dilakukan fitting model dengan api00 sebagai respons dan yr_rnd sebagai prediktor indikator. . regress api00 yr_rnd Source | SS df MS --------+------------------------Model |1825000.56 1 1825000.56 Residual|6248671.43 398 15700.1795 --------+------------------------Total |8073672 399 20234.7669 11 Number of obs F( 1, 398) Prob > F R-squared Adj R-squared Root MSE = = = = = = 400 116.24 0.0000 0.2260 0.2241 125.3 ------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+----------------------------------------------------yr_rnd | -160.5064 14.8872 -10.78 0.000 -189.7737 -131.239 _cons | 684.539 7.13965 95.88 0.000 670.5028 698.5751 ------------------------------------------------------------. Model estimasi adalah: api00 = 684.54 – 160.51 yr_rnd + e Prediktor yr_rnd bermakna secara statistik (p = 0.000). Untuk yr_rnd = 0, api00 bernilai 684.54 (sama dengan estimasi intersep), sedangkan untuk yr_rnd = 1, api00 adalah (684.54 − 160.51) ≈ 524.03. 12 BAB 3 REGRESI LINEAR GANDA Regresi linear ganda (multiple linear regression) adalah model regresi linear dengan 1 variabel dependen kontinu beserta k (dua atau lebih) variabel independen kontinu dan/atau kategorik. Regresi Linear Ganda dengan Prediktor Kontinu Model untuk regresi linear ganda yaitu: Yi = β 0 + β 1 X1i + β 2 X 2i + . . . + β k X ki + ε i Perintah Stata untuk fitting regresi linear ganda dengan prediktor kontinu adalah regress var_dep vars_indep [if] [in] [, options] var_dep : vars_indep : Variabel dependen Himpunan variabel independen kontinu β 0 , β 1 , β 2 , . . . , β k adalah nilai-nilai parameter yang akan diestimasi dengan perintah Stata tersebut. Sebagai keluaran akan diperoleh estimasi persamaan garis regresi linear ganda: Yˆi = b 0 + b1 X1i + b 2 X 2i + . . . + bk X ki ; i = 1, 2, . . . , n 13 Contoh 3.1: . use “D:\Analisis Regresi Linear\Data\elemapi”, clear Variabel-variabel yang akan digunakan dalam contoh ini yaitu: api00 : Kinerja akademik sekolah tahun 2000 acs_k3 : Rerata ukuran kelas dari TK s.d. kelas 3 meals : Persentase siswa yang mendapat makan gratis (indikator kemiskinan) full : Persentase guru yang memiliki akreditasi penuh untuk mengajar Sebagai gambaran, diperlihatkan sebagian nilai-nilai tersebut pada dataset: . list api00 acs_k3 meals full in 1/7 1. 2. 3. 4. 5. 6. 7. +---------------------------------+ | api00 acs_k3 meals full | |---------------------------------| | 693 16 67 76.00 | | 570 15 92 79.00 | | 546 17 97 68.00 | | 571 20 90 87.00 | | 478 18 89 87.00 | |---------------------------------| | 858 20 . 100.00 | | 918 19 . 100.00 | +---------------------------------+ Diagram tebar untuk tiap pasangan variabel tersebut dalam bentuk matriks adalah: . graph matrix api00 acs_k3 meals full, half 14 api 2000 20 avg class size k-3 0 -20 100 pct free meals 50 0 100.00 pct full credential 50.00 0.00 400 600 800 1000 -20 0 20 0 50 100 Matriks korelasi diperoleh dengan perintah: . correlate api00 acs_k3 meals full (obs=313) | api00 acs_k3 meals full -------------+-----------------------------------api00 | 1.0000 acs_k3 | -0.0641 1.0000 meals | -0.8184 0.0097 1.0000 full | 0.2328 0.1789 -0.2518 1.0000 Selanjutnya dilakukan fitting model regresi linear ganda: . regress api00 acs_k3 meals full Source | SS df MS ---------+---------------------------Model | 2634884.26 3 878294.754 Residual | 1271713.21 309 4115.57673 ---------+---------------------------Total | 3906597.47 312 12521.1457 15 Number of obs F( 3, 309) Prob > F R-squared Adj R-squared Root MSE = = = = = = 313 213.41 0.0000 0.6745 0.6713 64.153 -------------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-----------------------------------------------------------acs_k3 | -2.681508 1.393991 -1.92 0.055 -5.424424 .0614073 meals | -3.702419 .1540256 -24.04 0.000 -4.005491 -3.399348 full | .1086104 .090719 1.20 0.232 -.0698947 .2871154 _cons | 906.7392 28.26505 32.08 0.000 851.1228 962.3555 -------------------------------------------------------------------Interpretasi terhadap keluaran berikut adalah: -` Variabel rerata ukuran kelas acs_k3 dengan koefisien regresi b = −2.68 tidak jelas kebermaknaannya (p = 0.055). Koefisien regresi yang negatif menyatakan bahwa ukuran kelas yang lebih besar terkait dengan kinerja akademik lebih rendah. - Efek meals dengan koefisien regresi b = −3.70 (p = 0.000) tampak bermakna. Koefisien regresi yang negatif mengindikasikan bahwa semakin besar proporsi siswa penerima makanan gratis, semakin rendah kinerja akademik. Ini tidak berarti bahwa makanan gratis menyebabkan kinerja akademik yang rendah. Variabel meals terkait erat dengan tingkat penghasilan dan berfungsi sebagai proxy untuk kemiskinan. Tingkat kemiskinan yang lebih tinggi diasosiasikan dengan kinerja akademik yang lebih rendah. - Persentase guru dengan akreditasi penuh full dengan koefisien regresi b = 0.11 (p = 0.232) tak terkait dengan kinerja akademik. Ini mengindikasikan bahwa persentase guru dengan akreditasi penuh bukan merupakan faktor penting untuk memprediksi kinerja akademik sekolah. 16 Regresi Linear Ganda dengan Prediktor Kategorik Non-Biner Misalkan dimiliki variabel ramdom kontinu Y dan variabel kategorik X dengan 3 kategori, X = {1, 2, 3}. Misalkan pula hendak dilakukan regresi X terhadap Y, maka X harus terlebih dahulu ditransformasikan menjadi 2 variabel indikator Z1 dan Z 2 ; Z1 = {0, 1} dan Z 2 = {0, 1}. Pada Stata, transformasi variabel kategorik menjadi variabel indikator dilakukan dengan menggunakan operator i. Tiap variabel kategorik X dengan p taraf oleh operator i., yaitu i.X ditransformasikan menjadi (p – 1) indikator Z. Misalnya variabel kategorik X dengan 3 taraf ditransformasikan menjadi 2 variabel indikator Z1 dan Z 2 . X=1 X=2 X=3 Z1 Z2 0 1 0 0 0 1 Model yang diinginkan untuk regresi X terhadap Y menjadi regresi linear Z terhadap Y, yaitu: Yi = β 0 + β 1 Z1i + β 2 Z 2i + ε i Model regresi linear dengan satu prediktor kategorik non-biner (dengan taraf lebih daripada dua) dapat dianggap sebagai regresi linear ganda, karena pada fitting modell diperlakukan memiliki (p – 1) variabel independen indikator dengan (p – 1) estimator koefisien regresi. Perintah Stata untuk regresi linear ganda dengan prediktor kategorik (non-biner) adalah: regress depvar i.indepvar(s) [if] [in] [, options] 17 Tanpa operator i., prediktor akan dianggap sebagai variabel kontinu. Variabel indikator yang terbentuk dengan operator i. dan digunakan untuk fitting model tidak tersimpan dalam dataset. Jika diinginkan (p – 1) variabel indikator yang terbentuk tersimpan dalam dataset, perintah Stata adalah: xi: regress depvar i.indepvar(s) [if] [in] [, options] Contoh 3.2: . use “D:\Analisis Regresi Linear\Data\hsb2.dta”, clear (highschool and beyond (200 cases)) . tabulate ses ses | Freq. Percent Cum. ------------+----------------------------------low | 47 23.50 23.50 middle | 95 47.50 71.00 high | 58 29.00 100.00 ------------+----------------------------------Total | 200 100.00 . tabulate ses, nolabel ses | Freq. Percent Cum. ------------+----------------------------------1 | 47 23.50 23.50 2 | 95 47.50 71.00 3 | 58 29.00 100.00 ------------+----------------------------------Total | 200 100.00 Selanjutkan dilakukan fitting model. Variabel kategorik ses dengan 3 taraf akan direpresentasikan oleh 2 variabel indikator yang dibentuk oleh i.ses (X = 1 menjadi baseline). . regress science i.ses 18 Source | SS df MS ---------+-------------------------Model | 1561.57802 2 780.789008 Residual | 17945.922 197 91.0960507 ---------+-------------------------Total | 19507.5 199 98.0276382 Number of obs F( 2, 197) Prob > F R-squared Adj R-squared Root MSE = = = = = = 200 8.57 0.0003 0.0801 0.0707 9.5444 ---------------------------------------------------------science | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+------------------------------------------------ses | middle| 4.003135 1.702093 2.35 0.020 .6464741 7.359797 high | 7.746148 1.873189 4.14 0.000 4.052072 11.44022 | _cons | 47.70213 1.392197 34.26 0.000 44.9566 50.44765 ---------------------------------------------------------Dengan awalan perintah (command prefix) xi: . xi: regress science i.ses i.ses _Ises_1-3 (naturally coded; _Ises_1 omitted) Source | SS df MS ---------+---------------------------Model | 1561.57802 2 780.789008 Residual | 17945.922 197 91.0960507 ---------+---------------------------Total | 19507.5 199 98.0276382 19 Number of obs F(2, 197) Prob > F R-squared Adj R-squared Root MSE = = = = = = 200 8.57 0.0003 0.0801 0.0707 9.5444 --------------------------------------------------------------science | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+-----------------------------------------------------_Ises_2 | 4.003135 1.702093 2.35 0.020 .6464741 7.359797 _Ises_3 | 7.746148 1.873189 4.14 0.000 4.052072 11.44022 _cons | 47.70213 1.392197 34.26 0.000 44.9566 50.44765 --------------------------------------------------------------Taraf low pada variabel kategorik ses menjadi baseline untuk kontras (middle vs low dan high vs low). Tampak bahwa baik kontras ses untuk middle vs low maupun untuk high vs low, keduanya bermakna, masing-masing dengan nilai p = 0.02 dan p = 0.00. Tampak pula bahwa untuk middle = 0 dan high = 0, nilai science adalah 47.70, sedangkan jika middle = 0 dan high = 1, nilai science menjadi (47.70 + 7.75) = 55.45. Perhatikan pula bahwa tidak mungkin terjadi kombinasi nilai middle = 1 dan high = 1. Regresi Linear Ganda dengan Interaksi Misalkan hendak diregresikan variabel random X 1 dan X2 besertanya interaksinya terhadap variabel random kontinu Y dengan model: Yi = β 0 + β 1 X1i + β 2 X 2i + β 3 X1i X 2i + ε i Untuk model regresi dengan interaksi ini, selain operator i. yang mentransformasikan variabel kategorik dengan k taraf menjadi (k – 1) variabel indikator, akan diperkenalkan pula operator c. yang kegunaannya akan dibahas di bawah ini. Pada model dengan interaksi, suku-suku yang ada pada ruas kanan persamaan dibedakan menjadi (a) suku variabel tunggal yang tidak 20 menyatakan interaksi, disebut sebagai efek utama (main effects) dan (b) suku perkalian dua (atau lebih) variabel tunggal yang menyatakan suku interaksi. Yang dapat dijadikan efek utama adalah variabel indikator, variabel kontinu, atau variabel kategorik dengan operator i.; menjadi i.varname. Yang dapat dimasukkan dalam suku interaksi adalah variabel indikator, variabel kategorik, atau variabel kontinu dengan operator c.; menjadi c.varname. Contoh 3.3: . use “D:\Analisis Regresi Linear\Data\honolulu.dta”, clear Berikut diperlihatkan beberapa contoh regresi linear ganda. Contoh pertama adalah regresi linear ganda dengan 2 prediktor kontinu, yaitu usia dan kolesterol. . regress tek_darah usia kolesterol Source | SS df MS ---------+--------------------------Model | 3404.78195 2 1702.39098 Residual | 41118.218 97 423.899155 ---------+--------------------------Total | 44523 99 449.727273 21 Number of obs F( 2, 97) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 4.02 0.0211 0.0765 0.0574 20.589 ----------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] ----------+-----------------------------------------------------usia | .8469443 .408067 2.08 0.041 .0370443 1.656844 kolesterol| .0906782 .0535687 1.69 0.094 -.0156407 .1969972 _cons | 64.97095 23.74061 2.74 0.007 17.85242 112.0895 ----------------------------------------------------------------Contoh berikut ini menunjukkan regresi linear ganda dengan 2 prediktor kontinu, usia dan kolesterol, serta interaksi antara keduanya. Variabel kontinu dalam suku interaksi harus mendapat operator c. agar tidak dianggap sebagai variabel kategorik dalam suku interaksi. . regress tek_darah usia kolesterol c.usia#c.kolesterol Source | SS df MS ---------+--------------------------Model | 4127.36425 3 1375.78808 Residual | 40395.6358 96 420.787872 ---------+--------------------------Total | 44523 99 449.727273 Number of obs F( 3, 96) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 3.27 0.0246 0.0927 0.0643 20.513 ------------------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] ----------------+-------------------------------------------------------usia | 4.383427 2.729183 1.61 0.112 -1.033959 9.800813 kolesterol | .9399724 .6503 1.45 0.152 -.3508628 2.230808 | c.usia# | c.kolesterol | -.0158138 .0120677 -1.31 0.193 -.0397681 .0081404 | _cons | -124.6174 146.5978 -0.85 0.397 -415.6118 166.377 ------------------------------------------------------------------------- 22 Contoh di bawah ini menunjukkan regresi linear ganda dengan 1 prediktor kontinu, usia, dan 1 prediktor kategorik biner, rokok. . regress tek_darah usia rokok Source | SS df MS ---------+--------------------------Model | 2485.12693 2 1242.56346 Residual | 42037.8731 97 433.380135 ---------+--------------------------Total | 44523 99 449.727273 Number of obs F( 2, 97) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 2.87 0.0617 0.0558 0.0363 20.818 ----------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] -----------------------------------------------------usia | .9466804 .4112442 2.30 0.023 .1304745 1.762886 rokok | 3.566772 4.323255 0.83 0.411 -5.013693 12.14724 _cons | 77.97196 22.34209 3.49 0.001 33.6291 122.3148 ----------------------------------------------------------------Contoh selanjutnya memperlihatkan regresi linear ganda dengan 1 prediktor kontinu usia, 1 prediktor kategorik biner rokok, serta interaksi antara keduanya. Variabel kontinu usia dalam suku interaksi diberi operator c. . regress tek_darah usia rokok c.usia#rokok Source | SS df MS ---------+--------------------------Model | 2531.81794 3 843.939314 Residual | 41991.1821 96 437.408146 ---------+--------------------------Total | 44523 99 449.727273 23 Number of obs F( 3, 96) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 1.93 0.1300 0.0569 0.0274 20.914 -------------------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------------+------------------------------------------------------------usia | 1.040749 .5035781 2.07 0.041 .041154 2.040343 rokok | 18.94451 47.26727 0.40 0.689 -74.88028 112.7693 | rokok# | c.usia | 1 | -.2877643 .8807723 -0.33 0.745 -2.036083 1.460555 | _cons | 72.89675 27.29671 2.67 0.009 18.7132 127.0803 -------------------------------------------------------------------------Sekarang diperlihatkan regresi linear ganda dengan 1 prediktor kontinu, usia, dan 1 prediktor kategorik, pend. Variabel kategorik nonbiner yang dijadikan efek utama harus diberi operator i. menjadi i.pend untuk mengkonversinya menjadi variabel indikator. . regress tek_darah usia i.pend Source | SS df MS ---------+--------------------------Model | 3658.43513 5 731.687027 Residual | 40864.5649 94 434.729413 ---------+--------------------------Total | 44523 99 449.727273 24 Number of obs F( 5, 94) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 1.68 0.1462 0.0822 0.0333 20.85 ------------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] ----------+-------------------------------------------------------usia | .8387384 .420814 1.99 0.049 .0032023 1.674275 | pend | 2 | -1.292157 5.573684 -0.23 0.817 -12.35884 9.774523 3 | -.0548732 6.053667 -0.01 0.993 -12.07457 11.96482 4 | -12.39448 8.182403 -1.51 0.133 -28.64083 3.851877 5 | -7.623154 7.872033 -0.97 0.335 -23.25326 8.006951 | _cons | 87.38939 23.51743 3.72 0.000 40.69497 134.0838 ------------------------------------------------------------------Berikut ini adalah contoh regresi linear ganda dengan 1 prediktor kontinu dan 1 prediktor kategorik non-biner. Sebagai efek utama, variabel kategorik pend harus diberi operator i. menjadi i.pend, sedangkan dalam suku interaksi, variabel kontinu usia yang harus diberi operator c. menjadi c.usia. . regress tek_darah usia i.pend c.usia#pend Source | SS df MS ---------+----------------------------Model | 4941.84363 9 549.093736 Residual | 39581.1564 90 439.790626 ---------+----------------------------Total | 44523 99 449.727273 25 Number of obs F( 9, 90) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 1.25 0.2762 0.1110 0.0221 20.971 -----------------------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------------+---------------------------------------------------------------usia | 1.328125 .7005981 1.90 0.061 -.0637355 2.719985 | pend | 2 | 49.26815 52.90101 0.93 0.354 -55.82895 154.3652 3 | -11.77593 69.6128 -0.17 0.866 -150.0739 126.5221 4 | 17.71206 126.0571 0.14 0.889 -232.7224 268.1465 5 | 155.7896 116.6524 1.34 0.185 -75.96074 387.5399 | pend#c.usia | 2 | -.9249705 .9623264 -0.96 0.339 -2.8368 .9868588 3 | .2471469 1.303531 0.19 0.850 -2.342544 2.836838 4 | -.5503472 2.392998 -0.23 0.819 -5.304456 4.203761 5 | -3.089319 2.206097 -1.40 0.165 -7.472116 1.293478 | _cons | 60.47312 38.76049 1.56 0.122 -16.53136 137.4776 ------------------------------------------------------------------------------ 26 BAB 4 ASUMSI-ASUMSI PADA REGRESI LINEAR Beberapa asumsi pada model regresi linear yaitu: a. b. c. d. e. f. Model adekuat Asumsi linearitas Asumsi independensi dan non-otokorelasi Asumsi normalitas Asumsi homoskedatisitas Asumsi non-multikolinearitas. Kelima asumsi pertama berlaku untuk regresi linear sederhana maupun ganda, sedangkan asumsi terakhir hanya berlaku pada regresi linear ganda. Pada umumnya, seluruh asumsi-asumsi baru dapat dinilai validitasnya setelah dilakukan fitting model. Model Adekuat Asumsi ini menyatakan bahwa model yang diajukan peneliti harus adekuat untuk memprediksi respons. Asumsi ini dinilai dengan uji goodnessof-fit, yaitu uji F dengan hipotesis H 0 : β i = 0 untuk seluruh i (i = 1, 2, . . . , k) vs H1 : H 0 tidak benar (paling sedikit satu β i ≠ 0). Hasil uji F ini ditampilkan pada perintah regress Stata. Uji ini terutama penting pada regresi linear ganda, karena pada regresi linear sederhana, uji F untuk model pada hakekatnya sama dengan uji t untuk prediktor tunggalnya. 27 Contoh 4.1: Lihat kembali data dan hasil keluaran pada contoh 2.1. . use “ D:\Analisis Regresi Linear\Data\elemapi.dta”, clear . regress api00 enroll Source | SS df MS ---------+---------------------------Model | 817326.293 1 817326.293 Residual | 7256345.70 398 18232.0244 ---------+---------------------------Total | 8073672.00 399 20234.7669 Number of obs F( 1, 398) Prob > F R-squared Adj R-squared Root MSE = = = = = = 400 44.83 0.0000 0.1012 0.0990 135.03 Tampak nilai p untuk uji F adalah adalah 0.0000, sehingga hipotesis H 0 : β 1 = 0 ditolak dan model dianggap adekuat untuk memprediksi respons. Koefisien determinasi R 2 = 0.1012 menunjukkan bahwa prediktor enroll hanya “menjelaskan” 10% variasi pada respons. Asumsi Linearitas Asumsi linearitas menyatakan bahwa hubungan antara X dan Y linear. Secara kasar linearitas hubungan ini dapat dinilai dari diagram tebar X-Y, sedangkan penilaian secara lebih eksak adalah dengan uji lack-of-fit dengan H 0 : Tidak ada lack-of-fit vs H1 : Ada lack-of-fit. 28 Contoh 4.2: Lihat kembali data pada contoh 2.1. 400 600 800 1000 . graph twoway scatter api00 enroll || lfit api00 enroll 0 500 1000 number of students api 2000 1500 Fitted values Tampak bahwa tebaran titik-titik tidak terlalu jelas mengikuti garis regresi yang diestimasikan. Selanjutnya pemeriksaan asumsi linearitas diteruskan dengan uji lack-of-fit. . regress api00 enroll . maxr2 maximum R-square relative R-square actual adjusted R-square relative adjusted R-square = = = = 0.7917 0.1279 0.0990 0.1257 29 SSLF (df) = 5574305.5 (306) SSPE (df) = 1682040.3 (92) MSLF = 18216.684 MSPE = 18283.046 F (dfn, dfd) for lack-of-fit test (MSLF/MSPE) = 0.9964 (306,92) prob > F = 0.5206 number of covariate patterns = 308 as ratio of observations = 0.770 Dengan nilai p = 0.5206, hipotesis H 0 : Tidak ada lack-of-fit tidak ditolak. Asumsi Independensi dan Non-Otokorelasi Asumsi independensi dan non-otokorelasi menyatakan bahwa suku galat saling independen dan tak saling berkorelasi. Untuk data dari studi cross-sectional, asumsi ini dianggap telah terpenuhi jika data diperoleh melalui sampling acak (random sampling), walaupun independensi dapat lebih jelas dilihat dari grafik galat-respons. Pada data runtun waktu (time-series), asumsi non-otokorelasi diperiksa dengan uji Durbin-Watson, yang tak akan dibahas di sini. Contoh 4.3: Lihat data pada contoh 2.1. . regress api00 enroll Suku galat diperoleh dengan perintah berikut. . predict yhat 30 . gen e=api00-yhat Secara langsung, suku galat diperoleh dengan perintah: . predict e, residuals Perintah Stata berikut menampilkan plot residual (galat) vs prediktor: -400 -200 Residuals 0 200 400 . rvpplot enroll, yline(0) Tampak bahwa residual (galat) tersebar secara acak di atas dan di bawah garis horizontal 0, mengindikasikan bahwa residual (dan juga respons) saling independen. 31 Asumsi Normalitas Asumsi normalitas menyatakan bahwa suku galat berdistribusi normal dengan rerata nol. Asumsi ini dapat diperiksa dengan uji normalitas Kolmogorov-Smirnov atau uji Shapiro-Wilk untuk menguji hipotesis H 0 : Suku galat berdistribusi normal vs H1 : Suku galat tidak berdistribusi normal. Contoh 4.4: Lihat data pada contoh 2.1. . regress api00 enroll . predict e, residuals Dilakukan uji Shapiro-Wilk untuk menguji normalitas suku galat. . swilk e Shapiro-Wilk W test for normal data Variable | Obs W V z Prob>z ---------+-------------------------------------------e | 400 0.97083 8.030 4.957 0.00000 Dengan nilai p = 0.0000 hipotesis H 0 : Suku galat berdistribusi normal ditolak. 32 Asumsi Homoskedatisitas Asumsi homoskedastisitas menyatakan bahwa suku galat memiliki variansi konstan. Asumsi ini dapat diperiksa dengan uji Breusch-Pagan dan uji White, keduanya H0 : menguji Homoskedastisitas vs H1 : Heteroskedastisitas. Uji Breusch-Pagan ditujukan untuk menguji linear heteroskedasticity, sedangkan uji White menggunakan H1 : Unrestricted heteroskedasticity untuk menguji hourglass heteroskedasticity. Contoh 4.5: Lihat data pada contoh 2.1. . regress api00 enroll Uji Breusch-Pagan (untuk linear heteroskedasticity) adalah sebagai berikut: . estat hettest Breusch-Pagan / Cook-Weisberg test for heteroskedasticity Ho: Constant variance Variables: fitted values of api00 chi2(1) = 1.91 Prob > chi2 = 0.1665 Dengan p = 0.1665 hipotesis H 0 : Homoskedastisitas tidak ditolak (tidak ada linear heteroskedasticity). Selanjutnya dilakukan uji White (untuk menguji glasshour heteroskedasticity): 33 . estat imtest, white White's test for Ho: homoskedasticity against Ha: unrestricted heteroskedasticity chi2(2) = 3.78 Prob > chi2 = 0.1514 Cameron & Trivedi's decomposition of IM-test --------------------------------------------Source | chi2 df p -------------------+------------------------Heteroskedasticity | 3.78 2 0.1514 Skewness | 34.11 1 0.0000 Kurtosis | 26.44 1 0.0000 -------------------+------------------------Total | 64.32 4 0.0000 --------------------------------------------Dengan p = 0.1514, hipotesis H 0 : Homoskedastisitas tidak ditolak (tidak ada glasshour heteroskedasticity). Pada regresi linear ganda, dengan adanya lebih daripada satu variabel independen, pengujian keempat asumsi di atas harus dilakukan untuk pasangan variabel dependen dengan tiap variabel independennya satu-persatu. Asumsi Non-Multikolinearitas Asumsi non-multikoliearitas (hanya untuk regresi linear ganda) menyatakan bahwa tidak boleh ada korelasi yang “hampir sempurna” antar tiap pasangan variabel independen. Ada korelasi yang “hampir sempurna” dapat dinilai dengan memeriksa matriks korelasi antar variabel independen, 34 atau secara kuantitatif dengan menghitung nilai VIF (variance inflation factor) ataupun inversinya Tolerance = 1/VIF. Nilai VIF yang lebih besar daripada 10 atau nilai Tolerance yang kurang daripada 0.10 mengindikasikan adanya multi kolinearitas. Contoh 4.6: . use “D:\Analisis Regresi Linear\Data\elemapi.dta”, clear Variabel-variabel pada dataset ini adalah: api00 : Kinerja akademik sekolah tahun 2000 acs_k3 : Rerata ukuran kelas dari TK s.d. kelas 3 meals : Persentase siswa yang mendapat makan gratis (indikator kemiskinan) full : Persentase guru yang memiliki akreditasi penuh untuk mengajar Sebagian dari nilai-nilai pada dataset diperlihatkan sebagai berikut: . list api00 acs_k3 meals full in 1/7 1. 2. 3. 4. 5. 6. 7. +---------------------------------+ | api00 acs_k3 meals full | |---------------------------------| | 693 16 67 76.00 | | 570 15 92 79.00 | | 546 17 97 68.00 | | 571 20 90 87.00 | | 478 18 89 87.00 | |---------------------------------| | 858 20 . 100.00 | | 918 19 . 100.00 | +---------------------------------+ 35 Matriks korelasi yang disajikan dalam bentuk diagram tebar adalah: . graph matrix api00 acs_k3 meals full, half api 2000 20 avg class size k-3 0 -20 100 pct free meals 50 0 100.00 pct full credential 50.00 0.00 400 600 800 1000 -20 0 20 0 50 100 Matriks korelasi diperoleh dengan perintah berikut: . correlate api00 acs_k3 meals full (obs=313) | api00 acs_k3 meals full -------------+-----------------------------------api00 | 1.0000 acs_k3 | -0.0641 1.0000 meals | -0.8184 0.0097 1.0000 full | 0.2328 0.1789 -0.2518 1.0000 Fitting model: . regress api00 acs_k3 meals full 36 Source | SS df MS ---------+-----------------------------Model | 2634884.26 3 878294.754 Residual | 1271713.21 309 4115.57673 ---------+-----------------------------Total | 3906597.47 312 12521.1457 Number of obs F( 3, 309) Prob > F R-squared Adj R-squared Root MSE = = = = = = 313 213.41 0.0000 0.6745 0.6713 64.153 -----------------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+---------------------------------------------------------------acs_k3 | -2.681508 1.393991 -1.92 0.055 -5.424424 .0614073 meals | -3.702419 .1540256 -24.04 0.000 -4.005491 -3.399348 full | .1086104 .090719 1.20 0.232 -.0698947 .2871154 _cons | 906.7392 28.26505 32.08 0.000 851.1228 962.3555 -----------------------------------------------------------------------Dilakukan uji multikolinearitas dengan perintah vif, perintah ini harus langsung diberikan setelah perintah regress: . vif Variable | VIF 1/VIF -------------+---------------------full | 1.11 0.903713 meals | 1.07 0.933517 acs_k3 | 1.04 0.964781 -------------+---------------------Mean VIF | 1.07 Tampak bahwa untuk ketiga variabel independen tidak ada nilai VIF yang lebih besar daripada 10 atau nilai Tolerance = 1/VIF yang kurang daripada 0.10, sehingga disimpulkan tidak ada multikolinearitas. 37 BAB 5 ESTIMASI KOEFISIEN REGRESI DAN INTERPRETASI HASIL Metode Estimasi Koefisien Regresi Metode estimasi yang paling umum digunakan untuk mengestimasi koefisien regresi linear adalah metode Kuadrat Terkecil (Ordinary Least Squares; OLS). Di sini hanya akan dibahas metode kuadrat terkecil untuk regresi linear sederhana. Misalkan dimiliki estimasi garis regresi untuk model regresi sederhana: Yˆi = b 0 + b1 X i Misalkan pula Q menyatakan jumlah kuadrat galat, yaitu: n Q= ei2 ∑ i =1 (5.1) Metode kuadrat terkecil meminimumkan jumlah kuadrat galat Q dengan syarat derivat partial Q terhadap b 0 dan b1 masing-masing sama dengan nol: ∂Q =0 ∂b0 dan ∂Q =0 ∂b1 (5.2) =0 (5.3.a) ∑ X iYi = 0 (5.3.b) sehingga diperoleh: n b 0 + b1 ∑ X i − dan b0 ∑ Xi ∑ Yi + b1 ∑ X i2 − 39 Diperoleh rumus untuk koefisien regresi b1 : b1 = dan ∑ ( X i − X )(Yi − Y ) 2 ∑( Xi − X ) (5.4) b 0 = Y − b1 X (5.5) Tabel Analisis Variansi Keluaran hasil analisis regresi dengan Stata akan menampilkan dua tabel, yaitu tabel analisis variansi dengan hasil pelengkapnya dan tabel koefisien regresi. Dari model: Yi = β 0 + β 1 X i + ε i diperoleh estimasi model: Yi = b 0 + b1 X i + ei sehingga: Var (Yi ) = Var ( b 0 + b1 X i + e i ) Var (Yi ) = Var ( b 0 ) + Var ( b1 X i ) + Var ( ei ) dan: b 0 adalah konstante, sehingga Var ( b 0 ) = 0 dan: Var (Yi ) = Var ( b1 X i ) + Var ( ei ) Pada tabel analisis variansi (tabel ANOVA), variansi variabel dependen Var (Yi ) diestimasi oleh jumlah kuadrat total (JKT). Penguraiannya dirinci pada tabel analisis variansi (tabel ANOVA) menjadi: 1. Jumlah kuadrat regresi (JKR) sebagai estimator untuk Var ( b1 X i ) : Menyatakan komponen variansi yang berkaitan dengan (“dijelaskan oleh”) model regresi; beserta 40 2. Jumlah kuadrat galat (jumlah kuadrat residual; JKG) sebagai estimator untuk Var ( e i ) : Menyatakan komponen variansi sisanya yang “tidak dijelaskan” oleh model. Jumlah kuadrat dibagi dengan derajat bebasnya menghasilkan rerata kuadrat, masing-masing yaitu “rerata kuadrat regresi” dan “rerata kuadrat galat” yang nilai-nilainya digunakan untuk uji F di bawah ini. Bentuk umum tabel analisis variansi ini adalah: Sumber Variasi Jumlah Kuadrat db Model Galat JKR JKG JKT k n–k–1 n–1 JKR : Jumlah Kuadrat Regresi JKG : Jumlah Kuadrat Galat (Jumlah Kuadrat Residual) JKT : Jumlah Kuadrat Total ; JKT = JKR + JKG db : derajat bebas ; db JKR = k Rerata Kuadrat RKR RKG db JKG = n – k – 1 db JKT = (db JKR) + (db JKG) =n–1 RKR : Rerata Kuadrat Regresi ; RKR = JKR / k RKG : Rerata Kuadrat Galat RKG = JKG / (n – k – 1) ; n : ukuran sampel k : jumlah variabel independen Sebagai pelengkap tabel analisis variansi, diperoleh pula hasil dan nilai estimasi: Uji F, yaitu uji statistik untuk keadekuatan model yang diajukan peneliti beserta nilai p-nya. Uji F menguji hipotesis H 0 : Model tak adekuat vs H1 : Model adekuat. 41 Statistik pengujinya adalah: Fuji = RKR JKR k = RKG JKG ( n − k − 1) (5.6) yang berdistribusi F dengan derajat bebas pembilang (numerator) = k dan derajat bebas penyebut (denominator) = n – k – 1; n menyatakan ukuran sampel; k menyatakan jumlah variabel independen. Perhatikan bahwa model yang “adekuat” belum tentu merupakan model yang “terbaik”. Koefisien determinasi R 2 (R-squared), yaitu proporsi variansi yang “dijelaskan oleh” model. Estimasinya adalah: yaitu: dan estimasi “penyesuaian”-nya adj R 2 (adjusted R 2 ), masing-masing yaitu: R2 = JKR JKT - JKG = JKT JKT (5.7) Sebagian ahli menganggap nilai R 2 sebagai estimasi yang bias terhadap proporsi variansi yang “dijelaskan oleh” model, sehingga diperlukan penyesuaian menjadi adjusted R-squared: adj R 2 1 − R2 ) ( =1− ( n − 1) n − p −1 (5.8) p menyatakan jumlah variabel independen dalam model. Root MSE, yaitu akar RKG. Root MSE = RKG = JKG n − k −1 (5.9) Nilai ini akan digunakan pada sejumlah uji statistik pasca fitting model regresi. 42 Tabel Koefisien Regresi Tabel ini terutama berguna pada analisis regresi ganda. Pada analisis regresi sederhana dengan hanya satu variabel independen, nilai p untuk uji signifikansi koefisien regresinya adalah sama dengan nilai p untuk model pada uji F, tetapi pada analisis regresi ganda, dengan adanya beberapa variabel independen, tiap variabel independen akan memiliki nilai kemaknaan sendiri-sendiri, sehingga diperlukan tabel koefisien regresi untuk melihat kemaknaan masing-masing variabel independen. Bentuk umum tabel koefisien regresi adalah: Y Koeff SE t nilai p Int Konf 95% X1 b1 SEˆ ( b1 ) t1 p1 b1−low b1−high X2 b2 SEˆ ( b 2 ) t2 p2 b 2−low b 2−high ... ... ... ... ... ... ... Xk bk SEˆ ( bk ) tk pk bk −low bk −high Intersep b0 SEˆ ( b 0 ) t0 p0 b 0 −low b 0−high Kemaknaan tiap estimasi koefisien regresi diuji dengan uji Wald yang menggunakan uji t dengan statistik penguji: tuji = bj SEˆ b ( j) = bj RKG JKR yang berdistribusi t dengan derajat bebas (n – k – 1). 43 (5.10) Contoh 5.1: Lihat kembali contoh 2.1 dengan file data elemapi.dta, yang memuat data tentang kinerja akademik 400 sekolah di sebuah regio di Amerika Serikat. Perintah Stata regress menampilkan hasil tabel analisis variansi berserta pelengkapnya dan variabel koefisien regresi. Tabel analisis variansi beserta pelengkapnya adalah: Source | SS df MS ---------+---------------------------Model | 817326.293 1 817326.293 Residual | 7256345.70 398 18232.0244 ---------+---------------------------Total | 8073672.00 399 20234.7669 Number of obs F( 1, 398) Prob > F R-squared Adj R-squared Root MSE = = = = = = 400 44.83 0.0000 0.1012 0.0990 135.03 Tampak nilai JKT (Jumlah Kuadrat Total; Total) sebesar 8,073,672.00 dengan derajat bebas n – 1 = 399, yang dapat dijabarkan menjadi JKR (Jumlah Kuadrat Regresi) dan JKG (Jumlah Kuadrat Galat). JKR (SS Model) adalah 817,326.293 dengan derajat bebas k = 1 dan JKG (SS Residual) adalah 7,256,345.70 dengan derajat bebas n – k – 1 = 398. Pembagian tiap nilai Jumlah Kuadrat dengan derajat bebasnya (degree of freedom; df) menghasilkan nilai Rerata Kuadrat (MS). RKR (Rerata Kuadrat Regresi; MS Model) adalah 817,326.293 dan RKG (Rerata Kuadrat Galat; MS Residual) adalah 18,232.0244. Pembagian RKR dengan RKG menghasilkan statistik penguji [F(1, 398)] sebesar 44.83 dengan nilai-p (Prob > F) 0.0000, yang menyatakan hasil yang sangat bermakna, sehingga hipotesis H 0 : Model tak adekuat ditolak (paling sedikit salah satu prediktor bermakna untuk memprediksi respons). Koefisien determinasi (R-squared) adalah 0.1012, mengindikasikan bahwa model dengan 1 prediktor enroll (jumlah siswa) hanya dapat menjelaskan 10.12% variansi respons api00 (kinerja akademik sekolah pada tahun 2000). Penyesuaian koefisien variansi (Adj R44 squared) sebesar 0.0990 hanya menghasilkan sedikit perubahan, yaitu model tetap hanya dapat menjelaskan 9.90% variansi respons api00. Nilai Root MSE yaitu akar MS Residual adalah 135.03. Selanjutnya diperlihatkan tabel koefisien regresi, yaitu: ---------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-------------------------------------------------------enroll | -.1998674 .0298512 -6.70 0.000 -.2585532 -.1411817 _cons | 744.2514 15.93308 46.71 0.000 712.9279 775.5749 ---------------------------------------------------------------Dari tabel ini tampak bahwa respons adalah api00, sedangkan prediktor hanya ada 1 yaitu enroll. Dengan nilai-nilai estimasi yang ada untuk koefisien regresi (Coef.), maka estimasi model adalah: api00 = 744 – 0.200 enroll + e Pembagian tiap nilai estimasi koefisien regresi (Coef.) dengan standard error-nya (Std. Err.) menghasilkan nilai t (t), yaitu statistik penguji untuk tiap hipotesis H 0 : bj = 0 (uji Wald untuk tiap koefisien regresi) dengan nilai p-nya (P>|t|) masing-masing. Hasil uji bahwa hipotesis nol tidak ditolak mengindikasikan bahwa koefisien regresi bersangkutan “dapat dianggap” sama dengan nol, sehingga prediktor yang bersangkutan dapat dikeluarkan dari model. Nilai p untuk enroll adalah 0.000 yang sangat bermakna, sehingga prediktor enroll dapat dianggap sangat bermakna dalam memprediksi kinerja akademik sekolah. Estimasi untuk β 1 (Coef. enroll) adalah −0.200 dengan interval konfidensi 95% ([95% Conf. Interval]) untuk estimasi koefisien 45 regresi β 1 adalah [−0.259 ; −0.141]. Bagi estimasi koefisien regresi enroll yang bernilai negatif ini dapat diinterpretasikan bahwa tiap penambahanan 1 orang siswa (1 unit enroll) akan menurunkan kinerja akademik sekolah sebesar 0.200 satuan. Contoh 5.2: Lihat kembali contoh 3.1 yang juga menggunakan file data elemapi.dta dengan respons yang sama api00, tetapi pada model regresi linear ganda dengan 3 prediktor, yaitu acs_k3, meals, dan full. Tabel analisis variansi adalah: Source | SS df MS ---------+---------------------------Model | 2634884.26 3 878294.754 Residual | 1271713.21 309 4115.57673 ---------+---------------------------Total | 3906597.47 312 12521.1457 Number of obs F( 3, 309) Prob > F R-squared Adj R-squared Root MSE = = = = = = 313 213.41 0.0000 0.6745 0.6713 64.153 Ukuran sampel (Number of Obs) adalah n = 313 dan jumlah variabel independen (prediktor) adalah k = 3. Tampak nilai Jumlah Kuadrat Total (SS Total) sebesar 3,906,597.47 dengan derajat bebas (df Total) n – 1 = 312. Pada penguraiannya diperoleh Jumlah Kuadrat Regresi (SS Model) 2,634,884.26 dengan derajat bebas (df Model) k = 3 dan Jumlah Kuadrat Galat (SS Residual) 1,271,713.21 dengan derajat bebas (df Residual) n – k – 1 = 309. Pembagian Jumlah Kuadrat dengan derajat bebas menghasilkan Rerata Kuadrat, masing-masing yaitu Rerata Kuadrat Regresi (MS Model) sebesar 878,294.754 dan Rerata Kuadrat Galat (MS Residual) sebesar 46 4,115.577. Pembagian Rerata Kuadrat Regresi dengan Rerata Kuadrat Galat menghasilkan nilai statistik penguji untuk uji F [F( 3, 309)] untuk menguji hipotesis H 0 : Model tak adekuat vs H1 : Model adekuat, yaitu 213.41, yang berdistribusi F dengan derajat bebas pembilang 3 dan derajat bebas penyebut 309). Uji F ini menghasilkan nilai p (Prob > F) 0.000, sehingga hipotesis H 0 : Model tak adekuat ditolak (model dianggap adekuat). Koefisien determinasi (R-squared) adalah 0.674, R2 mengindikasikan bahwa 67.4% variansi respons api00 yang dapat “dijelaskan” oleh model. Penyesuaiannya menjadi adj R 2 squared) sebesar 0.671 atau 67.1%. (Adj R- Akar JKG (MS Residual) adalah Root MSE, yaitu 64.153. Selanjutnya tabel koefisien regresi adalah: -------------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-----------------------------------------------------------acs_k3 | -2.681508 1.393991 -1.92 0.055 -5.424424 .0614073 meals | -3.702419 .1540256 -24.04 0.000 -4.005491 -3.399348 full | .1086104 .090719 1.20 0.232 -.0698947 .2871154 _cons | 906.7392 28.26505 32.08 0.000 851.1228 962.3555 -------------------------------------------------------------------Tabel menunjukkan bahwa variabel respons adalah api00 dengan 3 prediktor, acs_k3, meals, dan full. Model estimasi adalah: api00 = 906.74 – 2.68 acs_k3 – 3.70 meals + 0.11 full + e Seandainya acs_k3 (rerata ukuran kelas), meals (persentasi siswa yang mendapat makan gratis), dan full (persentasi guru dengan akreditasi penuh) seluruhnya bernilai nol, maka api00 (kinerja akademik sekolah) akan bernilai 906.74. 47 Dari hasil uji Wald dengan uji t untuk ketiga estimasi koefisien regresi, tampak bahwa acs_k3 tidak jelas bermakna (p = 0.055), meals jelas bermakna (p = 0.000), dan full tidak bermakna (p = 0.232) terhadap respons api00. Kedua kolom terakhir menyatakan nilai batas bawah dan batas atas interval konfidensi 95%. Jika p > 0.5, maka batas bawah akan bernilai negatif dan batas atas positif, sedangkan jika p < 0.05, maka batas bawah dan atas akan keduanya bernilai negatif atau keduanya bernilai positif. 48 BAB 6 KONFAUNDING DAN INTERAKSI Konfaunding Misalkan pada hubungan antara prediktor X 1 dan respons Y , dimiliki prediktor lain X 2 yang juga mempengaruhi respons Y . Jika seandainya pengendalian terhadap X 2 (dengan menginkorporasikan X 2 ke dalam model) mengakibatkan perubahan besar hubungan antara prediktor pertama X 1 dengan Y , maka X 2 dikatakan sebagai konfaunder (confounder) dan fenomena ini dikatakan sebagai konfaunding (confounding) pada hubungan antara X 1 dan Y . Syarat konfaunding yaitu: a. X 2 berpengaruh terhadap Y b. X 2 juga berpengaruh terhadap X 1 . Model konfaunding yang paling sederhana dan paling lazim ditemukan demikian diperlihatkan pada gambar 6.1, yang sering juga disajikan sebagai X 1 ← X 2 → Y . Gambar 6.1 Model konfaunding Konfaunder X 2 umumnya merupakan variabel kategorik. Peristiwa konfaunding terjadi karena distribusi prediktor X 1 tak homogen pada berbagai taraf nilai konfaunder X 2 , walaupun demikian besar efek prediktor 49 X 1 terhadap respons Y (dinyatakan dengan koefisien regresinya) pada berbagai taraf nilai konfaunder X 2 ini adalah sama ataupun hampir sama. Misalkan dimiliki prediktor X 1 dan respons Y dengan model regresi sederhana sebagai berikut: Y = β0 + β1 X1 + ε (6.1) c Misalkan dimiliki pula konfaunder potensial X 2 , sehingga dengan inkorporasinya model regresi menjadi tersebut menjadi: Y = β0 + β1 X1 + β 2 X 2 + ε c (6.2) c Koefisien regresi β 1 pada model pertama disebut sebagai “koefisien c regresi kasar” (crude coefficient of regression), selanjutnya dinyatakan sebagai cr − β 1 , sedangkan koefisien regresi β 1 pada model kedua adalah c c ‘koefisien regresi suaian” (adjusted coefficient of regression), dinyatakan sebagai adj − β 1 . Besar konfaunding adalah selisih antara estimasi koefisien regresi kasar dengan estimasi suaiannya, yaitu: ∆b = cr − β 1 − adj − β 1 (6.3) c Keberadaan konfaunding tidak ditentukan berdasarkan uji statistik, melainkan berdasarkan penilaian substantif ranah bidang penelitian yang bersangkutan, akan tetapi dengan “rule of thumb” (aturan berdasarkan pengalaman), dapat dinyatakan bahwa konfaunding ada jika ∆b adj − β 1 lebih besar daripada 10%. 50 Walaupun tak selalu, pada umumnya konfaunder adalah variabel kategorik, dan dalam keadaan ini perlu diperiksa koefisien regresi prediktor terhadap respons pada tiap taraf kategori konfaunder, yaitu koefisien regresi spesifik-kategori. Koefisien regresi spesifik-kategori ini harus hampir sama, tetapi jelas berbeda dengan koefisien regresi “kasar”. Jika koefisien regresi spesifik-kategori jelas saling berbeda satu sama lain, hal ini mengindikasikan kemungkinan adanya interaksi. Untuk pemeriksaan konfaunder kontinu, cukup diperiksa dan diperbandingkan koefisien regresi “kasar” dan koefisien regresi “suaian”nya. Nilai yang jelas berbeda antar keduanya mengindikasikan kemungkinan konfaunding, dengan syarat tidak ada interaksi. Contoh 6.1: Konfaunder dalam suatu model regresi mungkin lebih daripada satu, sebagaimana diperlihatkan pada contoh di sini dengan hanya menggunakan diagram tebar. Pada diagram tebar pertama di bawah ini, tidak terlihat jelas adanya hubungan antara Skor Diet (banyaknya asupan makanan) dengan BMI (indeks massa tubuh). 51 Dengan mengendalikan konfaunfer pertama, yaitu faktor Usia sebagai variabel biner (Usia dewasa > 20 tahun vs Usia anak < 20 tahun) pada diagram kedua, tampak adanya kecenderungan kenaikan indeks massa tubuh yang sejalan dengan kenaikan asupan makanan di kedua kelompok Usia. Dengan mengendalikan faktor usia, yaitu mengkategorikan anggota sampel ke dalam dua kelompok usia, masing-masing “lebih daripada 20 tahun” serta “kurang daripada atau sama dengan 20 tahun”, tampak adanya hubungan linear antara asupan makanan dengan indeks massa tubuh di masing-masing kategori. Pengendalian konfaunder kedua, yaitu Jenis Kelamin (Pria vs Wanita) lebih memperjelas hubungan antara banyak asupan makanan dengan indeks massa tubuh (diagram ketiga di bawah ini), sedangkan besar hubungan di tiap kategori konfaunder (dinilai dengan koefisien regresinya) adalah kurang lebih sama. 52 Contoh 6.2 (Konfaunder kategorik): Sebagai contoh konfaunding di sini akan digunakan dataset Framingham.dta yang memuat data tentang 4,690 subjek dewasa berusia 30 s.d. 68 tahun. Variabel dependen adalah tekanan darah sistolik (sbp) dengan prediktor indeks massa tubuh (bmi) dan variabel kategorik biner age.cat sebagai konfaunder potensial. . use "D:\Analisis Regresi Linear\Data\framingham_confounding .dta", clear . sum sbp bmi Variable | Obs Mean Std. Dev. Min Max ---------+-------------------------------------------sbp | 4,699 132.7665 22.8011 80 270 bmi | 4,690 25.63171 4.094672 16.2 57.6 53 . tab age_cat Age | Categorical | Freq. Percent Cum. ------------+----------------------------------< 52 years | 3,309 70.42 70.42 >= 52 years | 1,390 29.58 100.00 ------------+----------------------------------Total | 4,699 100.00 . tab age_cat, nolabel Age | Categorical | Freq. Percent Cum. ------------+----------------------------------0 | 3,309 70.42 70.42 1 | 1,390 29.58 100.00 ------------+----------------------------------Total | 4,699 100.00 Untuk memperoleh koefisien regresi kasar bmi, variabel dependen sbp diregresikan terhadap bmi. Jika ditemukan konfaunder, harus dihitung korefisien regresi suaiannya, sedangkan jika tidak ditemukan konfaunder, koefisien regresi kasar ini akan menjadi koefisien regresi akhir. . regress sbp bmi Source | SS df MS ---------+----------------------------Model | 262347.407 1 262347.407 Residual | 2176529.37 4,688 464.276742 ---------+----------------------------Total | 2438876.78 4,689 520.127271 54 Number of obs F(1, 4688) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,690 565.07 0.0000 0.1076 0.1074 21.547 ---------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+--------------------------------------------------------bmi | 1.82675 .0768474 23.77 0.000 1.676093 1.977407 _cons | 85.93592 1.9947 43.08 0.000 82.02537 89.84647 ---------------------------------------------------------------Diperoleh koefiesien regresi kasar sementara cr − β 1 = 1.827, c sehingga estimasi model adalah: sbp = 85.936 + 1.827.bmi + e Koefisien regresi kasar cr − β 1 = 1.827 mengindikasikan bahwa kenaikan 1 c satuan bmi akan menyebabkan kenaikan sbp sebesar 1.827 satuan. Syarat bagi age_cat sebagai konfaunder yaitu variabel ini harus memiliki hubungan baik prediktor bmi maupun respons sbp. . regress bmi age_cat Source | SS df MS ---------+-----------------------------Model | 1597.05562 1 1597.05562 Residual | 77020.3199 4,688 16.4292491 ---------+-----------------------------Total | 78617.3755 4,689 16.7663415 Number of obs F(1, 4688) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,690 97.21 0.0000 0.0203 0.0201 4.0533 --------------------------------------------------------------bmi | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+-----------------------------------------------------age_cat | 1.279192 .1297432 9.86 0.000 1.024835 1.53355 _cons | 25.25395 .0705055 358.18 0.000 25.11572 25.39217 --------------------------------------------------------------- 55 . regress sbp age_cat Source | SS df MS ---------+-----------------------------Model | 282895.911 1 282895.911 Residual | 2159548.99 4,697 459.77198 ---------+-----------------------------Total | 2442444.9 4,698 519.890358 Number of obs F(1, 4697) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,699 615.30 0.0000 0.1158 0.1156 21.442 ----------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+-------------------------------------------------------age_cat | 17.00044 .6853591 24.81 0.000 15.65682 18.34407 _cons | 127.7377 .3727545 342.69 0.000 127.0069 128.4685 ----------------------------------------------------------------Tampak bahwa age_cat memiliki hubungan bermakna, baik dengan bmi maupun sbp. Selanjutnya akan diperlihatkan bahwa koefisien regresi prediktor bmi tidak berbeda bermakna antar berbagai taraf kategori konfaunder. . regress sbp if age_cat==0 Source | SS df MS ---------+-----------------------------Model | 136140.952 1 136140.952 Residual | 1037934.6 3,303 314.239962 ---------+-----------------------------Total | 1174075.55 3,304 355.349742 Number of obs F(1, 3303) Prob > F R-squared Adj R-squared Root MSE = = = = = = 3,305 433.24 0.0000 0.1160 0.1157 17.727 ---------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+--------------------------------------------------------bmi | 1.619515 .0778075 20.81 0.000 1.466959 1.772071 _cons | 86.82944 1.988993 43.65 0.000 82.92966 90.72923 ---------------------------------------------------------------56 . regress sbp bmi if age_cat==1 Source | SS df MS ---------+-----------------------------Model | 58365.6713 1 58365.6713 Residual | 923271.701 1,383 667.58619 ---------+-----------------------------Total | 981637.372 1,384 709.275558 Number of obs F(1, 1383) Prob > F R-squared Adj R-squared Root MSE = = = = = = 1,385 87.43 0.0000 0.0595 0.0588 25.838 --------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+-------------------------------------------------------bmi | 1.524472 .16304 9.35 0.000 1.204639 1.844304 _cons | 104.3127 4.381322 23.81 0.000 95.71796 112.9075 --------------------------------------------------------------Tampak bahwa kedua koefisien regresi tidak banyak berbeda, masing-masing yaitu 1.620 dan 1.524. Jika keduanya jelas berbeda, perlu dipertimbangkan kemungkinan interaksi. Setelah ditetapkan status age_cat sebagai konfaunder, langkah terakhir adalah menghitung koefisien regresi suaian. . regress sbp bmi age_cat Source | SS df MS ---------+-----------------------------Model | 477517.59 2 238758.795 Residual | 1961359.19 4,687 418.46793 ---------+-----------------------------Total | 2438876.78 4,689 520.127271 Number of obs F(2, 4687) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,690 570.55 0.0000 0.1958 0.1955 20.456 ---------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+------------------------------------------------------bmi | 1.588524 .0737103 21.55 0.000 1.444017 1.733031 age_cat | 15.00111 .6615513 22.68 0.000 13.70416 16.29806 _cons | 87.61209 1.895182 46.23 0.000 83.89664 91.32754 ---------------------------------------------------------------57 Estimasi model adalah sbp = 87.612 + 1.589.bmi + 15.001.age_cat + e dengan adj − β 1 = 1.589, yaitu kenaikan 1 satuan bmi akan menyebabkan kenaikan sbp sebesar 1.589 satuan. Tampak bahwa: ∆b = cr − β 1 − adj − β 1 c = 1.827 – 1.589 = 0.238 dan: 0.238 ∆b = = 0.150 = 15.0% 1.589 b adj c yang dengan “rule of thumb” mengindikasikan adanya konfaunding. Dalam penilaian secara substantif, kenaikan bmi sebesar 1 satuan yang tampaknya cukup bermakna bagi massa tubuh, ternyata hanya menghasilkan kenaikan tekanan darah sistolik “kasar” sebesar 1.827 mm Hg ataupun kenaikan “suaian” sebesar 1.589 mm Hg, keduanya relatif tak bermakna secara substantif, apalagi perubahannya karena koreksi konfaunding yang hanya sebesar (1.827 – 1.589) mm Hg = 0.238 mm Hg. Maka walaupun secara kuantitatif didapatkan adanya konfaunding, secara substantif fenomena konfaunding relatif tak penting untuk diperhitungkan ataupun dikoreksi. Contoh 6.3 (konfaunder kontinu): Pada contoh ini akan digunakan dataset framingham_confounding.dta yang sama seperti seperti pada Contoh 6.2, tetapi dengan memeriksa variabel age sebagai konfaunder potensial kontinu. . use “D:\Analisis Regresi Linear\Data\framingham _confounding.dta”, clear 58 . sum sbp bmi age Variable | Obs Mean Std. Dev. Min Max ---------+-----------------------------------------------sbp | 4,699 132.7665 22.8011 80 270 bmi | 4,690 25.63171 4.094672 16.2 57.6 age | 4,699 46.04107 8.504363 30 68 . regress sbp bmi Source | SS df MS ---------+----------------------------Model | 262347.407 1 262347.407 Residual | 2176529.37 4,688 464.276742 ---------+----------------------------Total | 2438876.78 4,689 520.127271 Number of obs F(1, 4688) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,690 565.07 0.0000 0.1076 0.1074 21.547 ---------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+--------------------------------------------------------bmi | 1.82675 .0768474 23.77 0.000 1.676093 1.977407 _cons | 85.93592 1.9947 43.08 0.000 82.02537 89.84647 ---------------------------------------------------------------Koefisien regresi kasar bmi adalah 1.827. . regress bmi age Source | SS df MS ---------+-----------------------------Model | 2559.28728 1 2559.28728 Residual | 76058.0882 4,688 16.2239949 ---------+-----------------------------Total | 78617.3755 4,689 16.7663415 59 Number of obs F(1, 4688) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,690 157.75 0.0000 0.0326 0.0323 4.0279 ---------------------------------------------------------------bmi | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+--------------------------------------------------------age | .0869364 .0069218 12.56 0.000 .0733663 .1005064 _cons | 21.63002 .3239954 66.76 0.000 20.99484 22.2652 ---------------------------------------------------------------. regress sbp age Source | SS df MS ---------+-----------------------------Model | 380213.315 1 380213.315 Residual | 2062231.59 4,697 439.052924 ---------+-----------------------------Total | 2442444.9 4,698 519.890358 Number of obs F(1, 4697) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,699 865.99 0.0000 0.1557 0.1555 20.954 -------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+------------------------------------------------------age | 1.057829 .0359468 29.43 0.000 .9873561 1.128301 _cons | 84.06298 1.68302 49.95 0.000 80.76347 87.36249 -------------------------------------------------------------Tampak bahwa age memiliki hubungan bermakna, baik dengan bmi maupun sbp. . regress sbp bmi age Source | SS df MS ---------+-----------------------------Model | 546405.806 2 273202.903 Residual | 1892470.97 4,687 403.770209 ---------+-----------------------------Total | 2438876.78 4,689 520.127271 60 Number of obs F(2, 4687) Prob > F R-squared Adj R-squared Root MSE = = = = = = 4,690 676.63 0.0000 0.2240 0.2237 20.094 ----------------------------------------------------------------sbp | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+---------------------------------------------------------bmi | 1.478067 .0728609 20.29 0.000 1.335225 1.620908 age | .9311772 .0351072 26.52 0.000 .8623506 1.000004 _cons | 52.01112 2.257478 23.04 0.000 47.58541 56.43684 ----------------------------------------------------------------Diperoleh koefisien regresi suaian bmi sebesar 1.478. Tampak bahwa: ∆b = cr − β 1 − adj − β 1 c = 1.827 – 1.478 = 0.349 dan: 0.349 ∆b = = 0.236 = 23.6% 1.478 b adj c yang bahkan lebih besar daripada untuk perhitungan age kategorik sebagai konfaunder potensial di atas, yang dengan “rule of thumb” juga mengindikasikan adanya konfaunding. Walaupun demikian, pada penilaian secara substantif, 1 satuan bmi sebesar relatif cukup bermakna bagi massa tubuh, hanya menghasilkan kenaikan tekanan darah sistolik “kasar” sebesar 1.827 mm Hg, kenaikan “suaian” sebesar 1.478 mm Hg, maupun perubahannya karena koreksi konfaunding sebesar 0.349 mm Hg, yang kesemuanya relatif tak bermakna secara substantif. Maka walaupun dengan konfaunder kontinu di sini secara kuantitatif didapatkan adanya konfaunding, secara substantif fenomena konfaunding tetap tak perlu untuk diperhitungkan ataupun dikoreksi. 61 Interaksi Interpretasi interaksi dapat dibedakan menjadi 2 konsep yang berbeda namun saling berkaitan, yaitu modifikasi efek (effect modification) dan interaksi statistik (statistical interaction). Modifikasi Efek Misalkan dimiliki hubungan antara prediktor X 1 dengan respons Y dalam model regresi sederhana: Y = β0 + β1 X1 + ε c Misalkan dimiliki pula variabel kategorik X 2 , sedemikian hingga besar hubungan antara X 1 dengan Y tidak tidak sama pada berbagai taraf nilai X 2 , maka peristiwa ini disebut sebagai modifikasi efek dengan X 2 sebagai pemodifikasi efek (effect modifier) –nya. Pada umumnya, perbedaan efek antara prediktor dengan respons pada berbagai taraf pemodifikasi efeknya ini dapat “dijelaskan secara substantif” sesuai dengan ranah bidang ilmu penelitian. Dengan adanya dugaan peristiwa modifikasi efek oleh X 2 ini, model yang perlu diuji menjadi: Y = β0 + β1 X1 + β 2 X 2 + β 3 X1 X 2 + ε c c c Perhatikan bahwa pada inklusi suku interaksi β 3 X 1 X 2 , aturan hirarki c interaksi mensyaratkan pula pemasukan suku β 2 X 2 dalam model. c Pengujian modifikasi efek secara statistik dapat dilakukan dengan uji Wald pada fitting model regresi, yang menguji hipotesis H 0 : β 3 = 0. c Adanya modifikasi efek disimpulkan dengan tingkat kemaknaan yang umumnya lebih besar daripada tingkat kemaknaan untuk koefisien regresi biasa, yaitu dengan α = 0.25. Seandainya tidak ditemukan modifikasi efek, maka model regresi dikembalikan ke model semula dengan menghapus baik 62 suku interaksi β 3 X 1 X 2 maupun suku pemodifikasi-efeknya β 2 X 2 c c menjadi: Y = β0 + β1 X1 + ε c Walaupun tidak selalu, pemodifikasi efek umumnya adalah variabel kategorik, dan dalam hal in model estimasi akhir harus dinyatakan secara terpisah untuk tiap taraf kategori pemodifikasi efek. Interaksi Statistik Misalkan dimiliki dua prediktor X 1 dan X 2 dengan respons Y dalam model regresi: Y = β0 + β1 X1 + β 2 X 2 + ε c c Interaksi statistik antara prediktor X 1 dan X 2 dinyatakan ada jika penjumlahan efek X 1 terhadap Y dan efek X 2 terhadap Y (efek harapan; expected effect) tidak sama dengan efek bersama X 1 dan X 2 terhadap Y (efek pengamatan; observed effect). Selisih antara keduanya menyatakan besar efek interaksi statistik X 1 dan X 2 terhadap Y , yang keberadaannya secara substantif tak selalu dapat dijelaskan menurut ranah bidang ilmu yang diteliti. Di sini model yang akan diuji interaksi statistiknya adalah: Y = β0 + β1 X1 + β 2 X 2 + β 3 X1 X 2 + ε c c c Pengujian statistik juga dilakukan dengan uji Wald pada fitting model regresi terhadap hipotesis H 0 : β 3 = 0, biasanya dengan tingkat signifikansi α = c 0.25. Seandainya pada uji statistik ini hipotesis nol tidak ditolak maka interaksi dianggap tidak ada dan tidak hanya suku interaksi β 3 X 1 X 2 yang c dikeluarkan dari model menjadi: Y = β0 + β1 X1 + β 2 X 2 + ε c c 63 Suku interaksi statistik biasanya berisikan perkalian antar dua variabel kontinu. Pengujian cukup dilakukan dengan uji Wald. Contoh 6.4: Dalam contoh ini akan diperlihatkan interaksi antar variabel kategorik dengan menggunakan dataset elemapi2.dta, yang memuat data mengenai 400 sekolah di Amerika Serikat. Variabel dependen adalah penampilan akademik sekolah pada tahun 2000 (api00) dengan dua prediktor kategorik, yaitu kategori kolese sekolah (collcat) serta kategori persentase siswa di sekolah yang mendapat makanan gratis (mealcat). Prediktor terakhir dapat dianggap sebagai indikator tingkat kemiskinan siswa sekolah. . use "D:\Analisis Regresi Linear\Data\elemapi2.dta", clear . sum api00 Variable | Obs Mean Std. Dev. Min Max ---------+-------------------------------------api00 | 400 647.6225 142.249 369 940 . tab collcat collcat | Freq. Percent Cum. ------------+----------------------------------1 | 129 32.25 32.25 2 | 134 33.50 65.75 3 | 137 34.25 100.00 ------------+----------------------------------Total | 400 100.00 64 . tab mealcat Percentage | free meals | in 3 | categories | Freq. Percent Cum. ------------+----------------------------------1 | 131 32.75 32.75 2 | 132 33.00 65.75 3 | 137 34.25 100.00 ------------+----------------------------------Total | 400 100.00 . regress api00 i.collcat i.mealcat collcat#mealcat Source | SS df MS ---------+---------------------------Model | 6243714.81 8 780464.351 Residual | 1829957.19 391 4680.19741 ---------+---------------------------Total | 8073672 399 20234.7669 Number of obs F(8, 391) Prob > F R-squared Adj R-squared Root MSE = = = = = = 400 166.76 0.0000 0.7733 0.7687 68.412 ------------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] ----------+-------------------------------------------------------collcat | 2 | 8.736877 15.57439 0.56 0.575 -21.88315 39.35691 3 | -34.76334 14.90052 -2.33 0.020 -64.05851 -5.468177 | mealcat | 2 | -227.5643 19.17628 -11.87 0.000 -265.2658 -189.8628 3 | -322.9954 14.03445 -23.01 0.000 -350.5878 -295.4029 | 65 collcat# mealcat 2#2 2#3 3#2 3#3 | | | 38.51777 24.19532 1.59 0.112 -9.051422 86.08697 | 6.177537 20.08262 0.31 0.759 -33.3059 45.66097 | 101.051 22.88808 4.42 0.000 56.05191 146.0501 | 82.57776 24.43941 3.38 0.001 34.52867 130.6268 | _cons | 816.9143 11.56373 70.64 0.000 794.1794 839.6492 ------------------------------------------------------------------Estimasi model adalah: ˆ api00 = 816.91 + 8.74 (2.collcat) – 34.76 (3.collcat) – 227.56 (2.mealcat) – 322 (3.mealcat) + 38.52 (2.collcat)*(2.mealcat) + 6.18 (2.collcat)*(3.mealcat) + 101.05 (3.collcat)*(2.mealcat) + 82.58 (3.collcat)*(3.mealcat) Dengan batasan p < 0.25 sebagai batas kemaknaan interaksi, estimasi persamaan regresi menjadi: ˆ api00 = 816.91 + 8.74 (2.collcat) – 34.76 (3.collcat) – 227.56 (2.mealcat) – 322 (3.mealcat) + 38.52 (2.collcat)*(2.mealcat) + 101.05 (3.collcat)*(2.mealcat) + 82.58 (3.collcat)*(3.mealcat) Nilai prediksi respons harus dinyatakan pada tiap taraf interaksi: - collcat = 2 (2.collcat = 1) dan mealcat = 2 (2.mealcat = 1) Nilai prediksi api00 adalah ˆ api00 = 816.91 + 8.74 (2.collcat) – 34.76 (3.collcat) – 227.56 (2.mealcat) – 322 (3.mealcat) + 38.52 (2.collcat)*(2.mealcat) + 101.05 (3.collcat)*(2.mealcat) + 82.58 (3.collcat)*(3.mealcat) 66 ˆ api00 = 816.91 + 8.74 (1) – 34.76 (0) – 227.56 (1) – 322 (0) + 38.52 (1)*(1) + 101.05 (0)*(1) + 82.58 (0)*(0) =` 636.61 - collcat = 2 (2.collcat = 1) dan mealcat = 3 (3.mealcat = 1) Nilai prediksi api00 adalah: ˆ api00 = 816.91 + 8.74 (1) – 34.76 (0) – 227.56 (0) – 322 (1) + 38.52 (1)*(0) + 101.05 (0)*(0) + 82.58 (0)*(1) = 503.65 - collcat = 3 (3.collcat = 1) dan mealcat = 2 (2.mealcat = 1) Nilai prediksi api00 adalah: ˆ api00 = 816.91 + 8.74 (0) – 34.76 (1) – 227.56 (1) – 322 (0) + 38.52 (0)*(1) + 101.05 (1)*(1) + 82.58 (0)*(0) = 655.64 - collcat = 3 (3.collcat = 1) dan mealcat = 3 (3.mealcat = 1) Nilai prediksi api00 adalah: ˆ api00 = 816.91 + 8.74 (0) – 34.76 (1) – 227.56 (0) – 322 (1) + 38.52 (0)*(0) + 101.05 (1)*(0) + 82.58 (1)*(1) = 643.78 Perbandingan antara 2.collcat dengan 3.collcat: . test 2.collcat 3.collcat ( 1) ( 2) 2.collcat = 0 3.collcat = 0 F( 2, 391) = 5.44 Prob > F = 0.0047 67 Perbandingan antara 2.mealcat dengan 3.meal.cat: . test 2.mealcat 3.mealcat ( 1) ( 2) 2.mealcat = 0 3.mealcat = 0 F( 2, 391) = 264.96 Prob > F = 0.0000 Pengujian untuk beberapa suku interaksi: . test 2.collcat#2.mealcat 2.collcat#3.mealcat 3.collcat#2.mealcat 3.collcat#3.mealcat ( ( ( ( 1) 2) 3) 4) 2.collcat#2.mealcat 2.collcat#3.mealcat 3.collcat#2.mealcat 3.collcat#3.mealcat F( 4, 391) = Prob > F = = = = = 0 0 0 0 6.63 0.0000 Prediksi nilai-nilai respons diperoleh dengan perintah: . predict pred (option xb assumed; fitted values) Perintah selanjutnya adalah untuk memperoleh rerata prediksi respons pada berbagai taraf interaksi: . table collcat mealcat, contents(mean pred) 68 ---------------------------------------| Percentage free meals in 3 | categories collcat | 1 2 3 ----------+----------------------------1 | 816.9143 589.35 493.9189 2 | 825.6512 636.6047 508.8333 3 | 782.1509 655.6377 541.7333 ---------------------------------------Perintah separate adalah untuk memisahkan variabel pred yang sebelumnya baru terbentuk dengan perintah predict menjadi 3 variabel berdasarkan taraf kategori collcat. . separate pred, by(collcat) storage display value variable name type format label variable label ------------------------------------------------------------pred1 float %9.0g pred, collcat == 1 pred2 float %9.0g pred, collcat == 2 pred3 float %9.0g pred, collcat == 3 Sekarang dapat dibuat grafik pred1, pred2, dan pred3 berdasarkan ketiga kategori mealcat. . graph twoway scatter pred1 pred2 pred3 mealcat, c(l l l) xlabel(1 2 3) sort 69 900 800 700 600 500 Konfaunding dan Interaksi Skema pemeriksaan konfaunding dan interaksi untuk 1 respons kontinu, 1 prediktor kontinu, dan 1 konfaunder potensial biner diperlihatkan pada gambar 6.2. Penjelasannya adalah sebagai berikut: 1. Hitung estimasi koefisien regresi stratum-spesifik prediktor terhadap respons. 2. Estimasi koefisien regresi stratum-spesifik pada kedua strata mungkin sama (atau hampir sama) ataupun jelas berbeda. 3. Jika keduanya sama atau hampir sama, yang perlu dipertimbangkan adalah konfaunding. Interaksi tidak mungkin ada. 4. Hitung estimasi koefisien regresi kasar dan suaian. 5. Estimasi koefisien regresi kasar dan suaian yang sama atau hampir sama mengindikasikan bahwa tidak ada konfaunding dan tidak ada interaksi. 70 6. Estimasi koefisien regresi dan kasar yang berbeda mengindikasikan adanya konfaunding. Gambar 6.2 Pemeriksaan konfaunding dan interaksi 7. Jika estimasi koefisien regresi stratum stratum-spesifik pada kedua strata jelas berbeda, hal ini mengindikasikan adanya interaksi. Seandainya interaksi ada, konfaunding tidak perlu (dan tidak dapat) diperiksa keberadaannya. 71 BAB 7 DIAGNOSTIKA REGRESI Diagnostika regresi (regression diagnostics) adalah sekumpulan statistik yang digunakan setelah proses fitting model terhadap data pengamatan, bertujuan memeriksa apakah model peneliti beserta asumsiasumsi yang diberlakukan konsisten dengan data pengamatan. Statistik dasar untuk pemeriksaan tersebut adalah galat (residual) dan adakalanya juga galat terskala-ulang (rescaled residuals). Galat adalah selisih antara nilai prediksi respons berdasarkan model peneliti dengan nilai respons aktual atau nilai pengamatan. Perolehan himpunan nilai galat yang tak relevan akan menimbulkan keraguan terhadap model peneliti ataupun asumsi yang diberlakukan. Dalam beberapa keadaan tertentu, keyakinan akan kebenaran model peneliti ataupun asumsi yang diberlakukan dapat dipulihkan dengan membuang beberapa kasus yang disebut pengamatan influensial (influential; berpengaruh) dari dataset. Outliers dan Pengamatan Influensial Outliers (data pencilan) adalah titik data yang terletak jauh dari garis regresi (pada regresi linear sederhana) atau dari hyperplane (pada regresi linear ganda), yang menunjukkan penyimpangan bermakna secara statistik dari model yang diasumsikan. Secara sederhana, outlier dapat dikatakan sebagai pengamatan dengan galat yang besar. Pengamatan influensial (influential observation) adalah titik data yang memiliki dampak yang relatif besar terhadap estimasi terhadap satu atau lebih parameter regresi. Inklusi pengamatan influensial tersebut pada fitting model akan menimbulkan perubahan yang nyata pada estimasi satu atau lebih parameter regresi. 73 Deteksi outliers dan pengamatan influensial dilakukan melalui pemeriksaan visual dengan menggunakan statistik khusus yang disebut diagnostika regresi (regression diagnostics). Diagnostika regresi merupakan statistik per kasus, yaitu akan ada satu nilai diagnostika regresi bagi tiap anggota dari n anggota sampel. Statistik influensial adalah sejumlah statistik yang dirancang untuk menilai efek atau pengaruh (influence) suatu observasi dalam penentuan hasil analisis regresi. Pada gambar 7.1 tampak diagram tebar untuk data hipotetis Anscombe (1973), fitting model sepenuhnya ditentukan titik pencilan yang ada di sudut kanan atas diagram. Jika observasi ini dihilangkan, maka estimasi kemiringan garis regresi (estimasi koefisien regresi) tak dapat ditentukan. Dengan demikian, observasi ini merupakan pengamatan influensial yang sangat berpengaruh terhadap fitting model regresi. Gambar 7.1 Contoh diagram tebar untuk data Anscombe (1973) Pendekatan yang umumnya diadopsi untuk mendeteksi observasi influensial ini adalah dengan memeriksa perubahan yang terjadi pada koefisien regresi jika suatu observasi dihilangkan. Statistik influensial yang digunakan dapat berbeda-beda, tergantung pada statistik hasil regresi yang diukur perubahannya ataupun standardisasi yang digunakan agar hasilnya dapat diperbandingkan antar pengamatan. Seluruh statistik influensial 74 tersebut dapat dihitung dari hasil regresi dengan menggunakan keseluruhan data. Observasi influensial dapat terjadi jika observasi tersebut merupakan data pencilan, atau memiliki nilai leverage yang tinggi, ataupun keduanya. Leverage Leverage adalah istilah yang digunakan dalam analisis regresi bagi observasi (pengamatan) yang memiliki nilai ekstrim pada satu atau lebih variabel independen. Efek titik-titik demikian yaitu mengharuskan fitting model mendekati nilai respons yang diobservasi, agar menghasilkan nilai galat (residual) yang kecil. Ukuran leverage adalah matriks H, yaitu matriks yang terbentuk pada regresi ganda, digunakan untuk memperoleh prediksi nilai respons yang terkait dengan nilai-nilai observasi melalui persamaan: ŷ = Hy (7.1) ŷ : Vektor prediksi respons y Vektor respons observasi : Matriks H yang disebut sebagai matriks hat (hatmatrix), merupakan matriks yang simetrik dan idempoten. Dinyatakan dalam X, H adalah: -1 H = X(X’X) X (7.2) Elemen diagonal matriks H seringkali berguna untuk secara diagnostik dalam menilai hasil analisis. Dengan Stata, perintah untuk mendapatkan leverage diberikan langsung setelah perintah regress, yaitu: 75 predict lev_name, hat lev_name : Nama variabel baru untuk prediksi nilai-nilai leverage pada dataset Grafik untuk leverage (leverage plot) diperoleh dengan perintah: avplot pred_var pred_var : Variabel prediktor Jarak Cook Jarak Cook (Cook’s distance) adalah statistik influensial yang dirancang untuk mengukur perubahan estimasi vektor parameter β β̂ pada fitting model regresinya jika suatu observasi tertentu dihilangkan. Jarak Cook merupakan ukuran gabungan dampak suatu observasi terhadap keseluruhan koefisien regresi. Jarak Cook untuk observasi ke-i didefinisikan sebagai: ri2 hi Di = tr ( H ) 1 − hi ri : (7.3) Galat terstandardisasi (standardized residual) untuk observasi ke-i Jika dimiliki galat berdistribusi normal dengan rerata 0 dan variansi σ ε2 , maka galat terstandardisasi adalah: ri = ei (7.3.a) σε hi : elemen diagonal ke-i matriks hat H : matriks hat, diperoleh dari analisis regresi 76 Jarak Cook yang lebih besar daripada 1 bagi sebuah observasi mengindikasikan bahwa observasi tersebut memiliki pengaruh (influence) yang berlebihan ataupun tak sebanding terhadap estimasi koefisien regresi. Dengan Stata, perintah untuk mendapatkan jarak Cook diberikan langsung setelah perintah regress, yaitu: predict new_var, cooksd new_var : Nama untuk variabel baru yang memuat nilai-nilai jarak Cook DFBETA DFBETA untuk observasi ke-i dan koefisien regresi ke-j adalah perubahan nilai estimasi koefisien regresi ke-j jika observasi ke-i dihilangkan dari analisis data. DFBETA dengan perubahan koefisien regresi ke-j dan penghilangan observasi ke-i adalah: DFBETA j ,−i = b j − b j ,−i (7.4) s−i c jj bj : Estimasi koefisien regresi ke-j b j ,−i : Estimasi koefisien regresi ke-j dengan menghilangkan observasi ke-j s− i : Estimasi standard error dengan menghilangkan observasi ke-i c jj : Unsur diagonal matriks ( X'X ) −1 Untuk mendeteksi observasi influensial, nilai batas DFBETA adalah 2 n . Dalam keadaan moderat dan ukuran sampel kecil, cukup digunakan nilai batas + 2. 77 Dengan Stata, perintah untuk mendapatkan nilai-nilai DFBETA diberikan langsung setelah perintah regress, yaitu: predict DF_pred, dfbeta(pred_var) DF_pred : Variabel baru untuk nilai-nilai DFBETA pred_var : Variabel prediktor Jika ada beberapa prediktor, untuk DFBETAS pada regresi dengan seluruh prediktor: . dfbeta Contoh 7.1: Lihat kembali contoh 2.1, yang menggunakan file data elemapi.dta. . regress api00 enroll Source | SS df MS ---------+---------------------------Model | 817326.293 1 817326.293 Residual | 7256345.70 398 18232.0244 ---------+---------------------------Total | 8073672.00 399 20234.7669 Number of obs F( 1, 398) Prob > F R-squared Adj R-squared Root MSE = = = = = = 400 44.83 0.0000 0.1012 0.0990 135.03 ---------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-------------------------------------------------------enroll | -.1998674 .0298512 -6.70 0.000 -.2585532 -.1411817 _cons | 744.2514 15.93308 46.71 0.000 712.9279 775.5749 ---------------------------------------------------------------78 Pertama akan diprediksi nilai-nilai galat dan akan ditentukan observasi dengan galat terbesar. . predict e, residuals . sum e Variable | Obs Mean Std. Dev. Min Max ---------+------------------------------------------------e | 400 1.08e-07 134.8567 -285.4997 389.148 . list api00 enroll e if e>389.147 +--------------------------+ | api00 enroll e | |--------------------------| 8. | 831 1513 389.148 | +--------------------------+ Didapatkan galat terbesar adalah untuk observasi nomor 8. Untuk memperoleh statistik leverage (diagonal matriks hat): . predict lvg, hat Diperoleh variabel baru lvg pada dataset, yang memuat nilai-nilai leverage untuk tiap observasi. . sum lvg 79 Variable | Obs Mean Std. Dev. Min Max ---------+---------------------------------------------lvg | 400 .005 .0056276 .0025 .0602 . list api00 enroll e lvg if lvg>.0601 +-----------------------------------+ | api00 enroll e lvg | |-----------------------------------| 210. | 493 1570 62.54047 .0602 | +-----------------------------------+ Tampak bahwa nilai lvg terbesar adalah 0.0602 dan nilai ini didapat untuk observasi nomor 210 dengan nilai api00 sama dengan 493 pada enroll sama dengan 1570, tetapi bukan untuk observasi dengan galat terbesar. Keputusan apakah observasi nomor 210 perlu dihilangkan dari dataset sepenuhnya tergantung pada pertimbangan dari segi ranah bidang ilmu perolehan data. Grafik leverage versus kuadrat galat ternormalisasi adalah: . lvr2plot 80 .06 .04 Leverage .02 0 Pada grafik terlihat juga bahwa observasi dengan leverage terbesar tidak sama dengan observasi dengan kuadrat galat ternormalisasi terbesar. Perintah untuk mendapatkan nilai Cook’s Distance D adalah: . predict new, cooksd Variabel baru new pada dataset memuat nilai-nilai jarak Cook untuk tiap observasi. . sum new Variable | Obs Mean Std. Dev. Min Max ---------+-----------------------------------------------new | 400 .0026611 .0127133 5.64e-10 .2521747 81 . list api00 enroll e lvg new if new>.2521746 +------------------------------------------------+ | api00 enroll e lvg new | |------------------------------------------------| 8. | 831 1513 389.148 .0543049 .2521747 | +------------------------------------------------+ Tampak bahwa nilai jarak Cook terbesar yaitu 0.252 didapatkan untuk observasi nomor 8, yang juga merupakan observasi dengan nilai galat terbesar. Untuk memperoleh nilai DFBETAS pada regresi dengan prediktor enroll: . predict DF_pred, dfbeta(enroll) . sum DF_pred Variable | Obs Mean Std. Dev. Min Max ---------+---------------------------------------------DF_pred | 400 .0000925 .053313 -.1519209 .700537 . list api00 enroll e lvg new DF_pred if DF_pred>.7005 +-----------------------------------------------------+ | api00 enroll e lvg new DF_pred | |-----------------------------------------------------| 8. | 831 1513 389.148 .0543049 .2521747 .700537 | +-----------------------------------------------------+ 82 Nilai DFBETAS terbesar adalah 0.7005, didapatkan untuk observasi nomor 8. Tampak bahwa penilaian galat terbesar, jarak Cook terbesar, dan DFBETAS terbesar memberi hasil yang konsisten, yaitu terjadi untuk observasi nomor 8, sedangkan leverage terbesar terjadi pada observasi nomor 210. Contoh 7.2: Lihat kembali contoh analisis regresi ganda pada contoh 3.1. . regress api00 acs_k3 meals full Source | SS df MS ---------+---------------------------Model | 2634884.26 3 878294.754 Residual | 1271713.21 309 4115.57673 ---------+---------------------------Total | 3906597.47 312 12521.1457 Number of obs F( 3, 309) Prob > F R-squared Adj R-squared Root MSE = = = = = = 313 213.41 0.0000 0.6745 0.6713 64.153 -------------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-----------------------------------------------------------acs_k3 | -2.681508 1.393991 -1.92 0.055 -5.424424 .0614073 meals | -3.702419 .1540256 -24.04 0.000 -4.005491 -3.399348 full | .1086104 .090719 1.20 0.232 -.0698947 .2871154 _cons | 906.7392 28.26505 32.08 0.000 851.1228 962.3555 -------------------------------------------------------------------Untuk memperoleh nilai-nilai galat: . predict e, residuals (87 missing values generated) 83 Untuk memperoleh statistik leverage (diagonal matriks hat): . predict lvg_1, hat (87 missing values generated) Perintah untuk mendapatkan nilai-nilai jarak Cook adalah: . predict distance, cooksd (87 missing values generated) Variabel baru distance memuat nilai-nilai jarak Cook. Estimasi nilai-nilai DFBETA untuk seluruh prediktor diperoleh dengan: . dfbeta (87 missing values generated) _dfbeta_1: dfbeta(acs_k3) (87 missing values generated) _dfbeta_2: dfbeta(meals) (87 missing values generated) _dfbeta_3: dfbeta(full) Diperoleh 3 variabel baru pada dataset, yaitu _dfbeta_1, _dfbeta_2, dan _dfbeta_3, masing-masing memuat nilai-nilai DFBETA untuk prediktor acs_k3, meals, dan full. Nilai terbesar untuk galat, leverage, jarak Cook, dan DFBETAS adalah: . sum e lvg_1 distance _dfbeta_1 _dfbeta_2 _dfbeta_3 84 Variable | Obs Mean Std. Dev. Min Max ----------+---------------------------------------------e | 313 -7.68e-08 63.84359 -195.6183 188.8671 lvg_1 | 313 .0127796 .0432135 distance | 313 .0045331 .0354736 .0033227 .7687116 1.39e-08 .626511 _dfbeta_1 | 313 .0038461 .0930495 -.1386698 1.576904 _dfbeta_2 | 313 -.0001792 .0560422 -.2267429 .2701659 ----------+---------------------------------------------_dfbeta_3 | 313 -.0009695 .0601078 -.3692697 .2131358 . list api00 enroll e lvg_1 distance _dfbeta_1 _dfbeta_2 _dfbeta_3 if e>188.8671 +-----------------------------------------------------------------------+ | api00 enroll e lvg_1 distance _dfbet~1 _dfbet~2 _dfbet~3 | |-----------------------------------------------------------------------| 271. | 690 230 188.8671 .012422 .0275976 .0309159 .2310598 .2131358 | |-----------------------------------------------------------------------| Tampak bahwa untuk observasi nomor 271 dengan galat terbesar, nilai-nilai leverage, jarak Cook, dan DFBETAS tak ada yang mencapai nilai maksimum. 85 BAB 8 BEBERAPA PENANGANAN PENYIMPANGAN ASUMSI Dalam berbagai situasi dan kondisi pengumpulan data sampel seringkali menghasilkan data yang tak memenuhi persyaratan asumsi untuk melakukan analisis regresi linear. Dalam keadaan demikian tindakan pada tahap pertama adalah memeriksa ulang proses pengumpulan dan pengukuran data. Jika tahap pertama ini tak dapat dikerjakan atau tidak memberi hasil yang diharapkan, pilihan yang dapat dilakukan pada tahap kedua adalah melakukan transformasi data. Jika tahap kedua ini juga tidak memberi hasil atau tidak ingin dikerjakan peneliti, pilihan terakhir adalah memperlunak asumsi yang akan dibahas di sini. Penyebab utama penyimpangan asumsi pada regresi linear umumnya disebabkan oleh adanya: (1) Heteroskedatisitas; (2) Kemencengan (skewness) yang menyebabkan ketidaknormalan distribusi data; dan (3) Adanya data pencilan (outliers). Penyimpangan asumsi pertama dan kedua ditangani dengan penggunaan estimasi variansi robust, sedangkan kelainan terakhir ditangani dengan metode regresi robust. Ketidakadekuatan akibat penyimpangan asumsi ini pada analisis regresi linear ditemukan antara lain pada uji hipotesis terhadap parameter regresi yang dihasilkan dengan metode kuadrat terkecil. Pada regresi linear ganda dapat ditemukan penyimpangan asumsi berupa multikolinearitas. Penanganannya dapat dilakukan dengan menghapus 1 atau lebih prediktor dari model, tetapi jika hal ini tak dapat dikerjakan, dapat dilakukan fitting model dengan metode regresi ridge. 87 Estimasi Variansi Robust Dua asumsi penting dalam regresi linear yaitu asumsi normalitas dan asumsi homoskedastisitas. Penyimpangan terhadap salah satu atau kedua asumsi ini akan menyebabkan tak adekuatnya pengendalian terhadap besar probabilitas kesalahan tipe I. Ketidakadekuatan akibat penyimpangan asumsi ini pada analisis regresi linear ditemukan antara lain pada uji hipotesis terhadap parameter regresi yang dihasilkan dengan metode kuadrat terkecil. Upaya untuk mengatasinya dapat dilakukan dengan menggunakan estimasi variansi robust, sebagai alternatif terhadap estimasi variansi OLS (ordinary least squares). Estimasi variansi robust diperoleh dengan metode yang tak sensitif terhadap penyimpangan ringan terhadap asumsi normalitas galat dan homogenitas variansi model. Tak ada batasan jelas mengenai berat penyimpangan asumsi yang mengindikasikan digunakannya prosedur estimasi robust. Dalam Stata, sintaks untuk melakukan estimasi variansi robust yaitu: regress depvar indepvars [if] [in], robust [options] depvar : Variabel dependen indepvars : Himpunan variabel independen robust Opsi robust untuk estimasi variansi. Jika opsi metode estimasi variansi tidak dispesifikasikan, default-nya adalah metode kuadrat terkecil (ordinary least squares; ols) : Contoh 8.1: Lihat kembali file data pada contoh 3.3. . use “D:\Analisis Regresi Linear\Data\honolulu.dta”, clear 88 Mula-mula diperlihat hasil fitting model dengan metode kuadrat terkecil seperti telah dilakukan pada contoh 3.3. . regress tek_darah usia kolesterol Source | SS df MS ---------+--------------------------Model | 3404.78195 2 1702.39098 Residual | 41118.218 97 423.899155 ---------+--------------------------Total | 44523 99 449.727273 Number of obs F( 2, 97) Prob > F R-squared Adj R-squared Root MSE = = = = = = 100 4.02 0.0211 0.0765 0.0574 20.589 ---------------------------------------------------------------------tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] -----------+---------------------------------------------------------usia | .8469443 .408067 2.08 0.041 .0370443 1.656844 kolesterol | .0906782 .0535687 1.69 0.094 -.0156407 .1969972 _cons | 64.97095 23.74061 2.74 0.007 17.85242 112.0895 ---------------------------------------------------------------------Pemeriksaan asumsi normalitas: . predict e, residuals . swilk e Shapiro-Wilk W test for normal data Variable | Obs W V z Prob>z ---------+---------------------------------------------e | 100 0.94108 4.865 3.509 0.00022 Dengan p = 0.00022, hipotesis H 0 : Galat berdistribusi normal ditolak. Selanjutnya diperiksa asumsi homogenitas variansi: 89 . estat hettest Breusch-Pagan / Cook-Weisberg test for heteroskedasticity Ho: Constant variance Variables: fitted values of tek_darah chi2(1) = 0.01 Prob > chi2 = 0.9164 Dengan p = 0.9164, hipotesis H 0 : Homogenitas variansi tidak ditolak. Selanjutnya akan dilakukan fitting model dengan metode estimasi variansi robust. . regress tek_darah usia kolesterol, robust Linear regression Number of obs = 100 F(3, 309) = 5.00 Prob > F = 0.0086 R-squared = 0.0765 Root MSE = 20.589 ----------------------------------------------------------------| Robust tek_darah | Coef. Std. Err. t P>|t| [95% Conf. Interval] -----------+----------------------------------------------------usia | .8469443 .3538266 2.39 0.019 .1446964 1.549192 kolesterol | .0906782 .0472369 1.92 0.058 -.0030739 .1844303 _cons | 64.97095 21.11918 3.08 0.003 23.05522 106.8867 ----------------------------------------------------------------Perbandingan beberapa statistik yang diperoleh pada fitting model dengan metode ols dan robust diperlihatkan sebagai berikut. 90 ols 4.02 0.0211 0.0765 robust 5.00 0.0086 0.0765 Coef. usia kolesterol _cons 0.847 0.091 64.971 0.847 0.091 64.971 Std. Err. usia kolesterol _cons 0.408 0.054 64.971 0.354 0.047 21.119 P>|t| usia kolesterol _cons 0.041 0.094 0.007 0.019 0.058 0.003 F(2, 97) Prob > F R-squared Tampak adanya perbedaan nilai statistik penguji F, walaupun dengan kedua metode hasilnya sama-sama bermakna; sedangkan estimasi koefisien determinasi R 2 dengan kedua metode sama. Untuk estimasi koefisien regresi, tampak bahwa estimasi koefisiennya tetap sama, tetapi estimasi standard error dan nilai p-nya yang berbeda, yaitu batas kemaknaan suatu prediktor akan lebih mudah tercapai pada estimasi variansi robust. Regresi Robust Regresi robust tidak sama dengan regresi linear dengan estimasi variansi robust. Regresi robust digunakan jika terdapat pengamatan luar yang mengubah nilai estimasi koefisien regresi secara substansial (“bad outlier”). 91 Sintaks regresi robust adalah: rreg depvar indepvars [if] [in] [, options] Opsi: genwt(newvar) : Membuat variabel newvar yang memuat bobot untuk tiap pengamatan. Pada regresi kuadrat terkecil bobot untuk tiap pengamatan sama dengan 1. Pada regresi robust, pengamatan dengan Cook’s D lebih besar daripada 1 secara otomatis dikeluarkan dari fitting model. Contoh 8.2: File data yang digunakan adalah crime.dta, yang memuat nilai angka kejahatan pada 51 negara bagian di AS. . use “D:\Analisis Regresi Linear\Data\crime.dta”, clear (crime data from agresti & finlay - 1997) Variabel-variabel dalam penelitian ini adalah: - sid : Nomor identitas negara bagian (state id) - state : Nama negara bagian - crime : Angka kejahatan per 100,000 penduduk - murder : Angka pembunuhan per 1,000,000 penduduk - pctmetro : Persentase penduduk yang tinggal di area metropolitan - pctwhite : Persentase penduduk kulit putih - pcths Persentase penduduk berpendidikan SLTA (high school) ke atas - poverty : Persentase penduduk di bawah garis kemiskinan - single Persentase penduduk yang menjadi single parent : : 92 Akan digunakan prediktor poverty dan single untuk memprediksi crime. . summarize crime poverty single Variable | Obs Mean Std. Dev. Min Max ---------+---------------------------------------------crime | 51 612.8431 441.1003 82 2922 poverty | 51 14.25882 4.584242 8 26.4 single | 51 11.32549 2.121494 8.4 22.1 Pada umumnya regresi linear dimulai dengan metode kuadrat terkecil yang dilanjutkan dengan beberapa prosedur diagnostika regresi untuk memeriksa keberadaan data pencilan. . regress crime poverty single Source | SS df MS ---------+---------------------------Model | 6879872.44 2 3439936.22 Residual | 2848602.3 48 59345.8813 ---------+---------------------------Total | 9728474.75 50 194569.495 Number of obs F(2, 48) Prob > F R-squared Adj R-squared Root MSE = = = = = = 51 57.96 0.0000 0.7072 0.6950 243.61 ----------------------------------------------------------------crime | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+-------------------------------------------------------poverty | 6.787359 8.988529 0.76 0.454 -11.28529 24.86001 single | 166.3727 19.42291 8.57 0.000 127.3203 205.425 _cons | -1368.189 187.2052 -7.31 0.000 -1744.59 -991.7874 ----------------------------------------------------------------Perintah lvr2plot berikut menghasilkan grafik galat terstandardisasi kuadrat dan leverage. 93 0 .2 Leverage .4 .6 . lvr2plot, mlabel(state) Tampak negara bagian DC, Florida, dan Missisippi memiliki nilai leverage yang tinggi ataupun galat yang besar. Selanjutnya akan dihitung Cook’s D dan diperlihatkan pengamatan dengan nilai Cook’s D yang besar. . predict d1, cooksd . list state crime poverty single d1 if d1>4/51, noobs +---------------------------------------------+ | state crime poverty single d1 | |---------------------------------------------| | ak 761 9.1 14.3 .125475 | | fl 1206 17.8 10.6 .1425891 | | ms 434 24.7 14.7 .6138721 | | dc 2922 26.4 22.1 2.636252 | +---------------------------------------------+ 94 Pengamatan untuk DC dihapus karena nilai Cook’s D-nya lebih besar daripada satu (mengindikasikan influensial yang berlebihan), selain itu DC bukan merupakan negara bagian AS. . predict r1, rstandard . gen absr1 = abs(r1) Sekarang data diurutkan dengan perintah gsort, perintah untuk mengurutkan nilai negatif abs(r1) dari besar ke kecil (descending). . gsort -absr1 . list state absr1 in 1/10, noobs +------------------+ | state absr1 | |------------------| | ms 3.56299 | | fl 2.902663 | | dc 2.616447 | | vt 1.742409 | | mt 1.460884 | |------------------| | me 1.426741 | | ak 1.397418 | | nj 1.354149 | | il 1.338192 | | md 1.287087 | +------------------+ Sekarang akan dilakukan regresi robust dengan perintah rreg disertai opsi gen(weight) untuk membentuk variabel baru weight yang memuat bobot final untuk tiap pengamatan. . rreg crime poverty single, gen(weight) 95 Huber Huber Huber Biweight Biweight Biweight Biweight iteration iteration iteration iteration iteration iteration iteration 1: 2: 3: 4: 5: 6: 7: maximum maximum maximum maximum maximum maximum maximum Robust regression difference difference difference difference difference difference difference in in in in in in in weights weights weights weights weights weights weights = = = = = = = .66846346 .11288069 .01810715 .29167992 .10354281 .01421094 .0033545 Number of obs = 50 F( 2, 47) = 31.15 Prob > F = 0.0000 ---------------------------------------------------------------crime | Coef. Std. Err. t P>|t| [95% Conf. Interval] --------+------------------------------------------------------poverty | 10.36971 7.629288 1.36 0.181 -4.978432 25.71786 single | 142.6339 22.17042 6.43 0.000 98.03276 187.235 _cons | -1160.931 224.2564 -5.18 0.000 -1612.076 -709.7849 ---------------------------------------------------------------Pengamatan untuk DC dihapus karena nilai Cook’s D-nya lebih besar daripada satu (mengindikasikan influensial yang berlebihan), selain itu DC juga bukan merupakan negara bagian AS. Tampak dihasilkannya estimasi koefisien regresi yang berbeda dengan regresi kuadrat terkecil. Selain itu tidak ada tampilan koefisien determinasi R-squared, koefisien determinasi suaian adj R-squared, ataupun estimasi root MSE. Perbandingan estimasi fitting model dengan regresi OLS dan regresi robust diperlihatkan sebagai berikut: 96 regresi ols 51 F (2 , 48) = 57.96 0.0000 regresi robust 50 F (2 , 47) = 31.15 0.0000 Coef. poverty single _cons 6.787 166.373 −1368.189 10.370 142.634 −1160.931 Std. Err. poverty single _cons 8.989 19.423 187.205 7.629 22.170 224.256 P>|t| poverty single _cons 0.454 0.000 0.007 0.181 0.000 0.000 No of obs F value Prob > F Tampak hasil-hasil yang cukup berbeda antara kedua metode regresi. . list state weight if state =="dc", noobs +----------------+ | state weight | |----------------| | dc . | +----------------+ Tampak bahwa negara bagian DC memang memiliki bobot 0, sehingga tidak diperhitungkan dalam analisis data. . sort weight . list sid state weight absr1 d1 in 1/10, noobs 97 +-----------------------------------------------+ | sid state weight absr1 d1 | |-----------------------------------------------| | 25 ms .02638862 3.56299 .6138721 | | 9 fl .11772218 2.902663 .1425891 | | 46 vt .59144513 1.742409 .0427155 | | 26 mt .66441582 1.460884 .016755 | | 20 md .67960728 1.287087 .0356962 | |-----------------------------------------------| | 14 il .69124917 1.338192 .0126569 | | 21 me .69766511 1.426741 .0223313 | | 31 nj .74574796 1.354149 .0222918 | | 19 ma .75392127 1.198541 .016399 | | 5 ca .80179038 1.015206 .0123064 | +-----------------------------------------------+ 0 violent crime rate 500 1000 1500 . twoway (scatter crime single [weight=weight], msymbol(oh)) if state !="dc" (analytic weights assumed) 98 Regresi Ridge Regresi ridge digunakan jika terdapat multikolinearitas pada data. Sintaks Stata adalah: ridgereg depvar indepvars [if] [in] , model(orr|grr1|grr2|grr3) Opsi: orr grr1 grr2 grr3 : : : : Model Ordinary Ridge Regression Model Generalized Ridge Regression Model Iterative Generalized Ridge Model Adaptive Generalized Ridge Contoh 8.3: . use “D:\Analisis Regresi Linear\Data\ridgereg1.dta”, clear Mula-mula dilakukan regresi OLS seperti biasa. . regress y x1 x2 x3 Source | SS df MS ---------+----------------------------Model | 6601.91542 3 2200.63847 Residual | 327.9304 16 20.49565 ---------+----------------------------Total | 6929.84582 19 364.728727 99 Number of obs F(3, 16) Prob > F R-squared Adj R-squared Root MSE = = = = = = 20 107.37 0.0000 0.9527 0.9438 4.5272 ------------------------------------------------------------y | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+-----------------------------------------------------x1 | 1.058783 .173579 6.10 0.000 .6908121 1.426754 x2 | .4522435 .6557569 0.69 0.500 -.9378991 1.842386 x3 | .1211505 1.087042 0.11 0.913 -2.183275 2.425576 _cons | 8.132845 8.921103 0.91 0.375 -10.77905 27.04474 ------------------------------------------------------------Untuk pemeriksaan asumsi non-multikolinearitas, pertama-tama akan diperiksa matriks korelasi antar variabel independen. . correlate x1 x2 x3 (obs=20) | x1 x2 x3 -------------+--------------------------x1 | 1.0000 x2 | 0.7185 1.0000 x3 | 0.9152 0.6306 1.0000 Tampak adanya korelasi yang cukup besar antara variabel x1 dan x3, yaitu r = 0.92; walaupun demikian masih akan dilakukan uji multikolinearitas dengan perintah vif. . vif Variable | VIF 1/VIF -------------+---------------------x1 | 7.73 0.129285 x3 | 6.21 0.160959 x2 | 2.09 0.479345 -------------+---------------------Mean VIF | 5.34 100 Tampak bahwa tidak ada variabel independen yang memiliki nilai vif lebih besar daripada 10 ataupun nilai Tolerance = 1/vif yang kurang daripada 0.10. Walaupun demikian, sebagai latihan akan dicoba melakukan fitting model dengan regresi ridge. Dalam perintah ridgereg berikut, opsi kr(#) menyatakan Ridge k Value dengan rentang nilai (0 < k < 1); mfx(lin) menyatakan bentuk fungsional adalah model linear, lmcol menyatakan permintaan untuk uji diagnostik multikolinearitas; dan diag menyatakan untuk menyatakan kriteria diagnostik seleksi model. Pada contoh regresi ridge di sini akan ditampilkan berturut-turut hasil fitting model dengan Ordinary Ridge Regression, beberapa nilai kriteria diagnostik untuk model, beberapa hasil uji diagnostik multikolinearitas . ridgereg y x1 x2 x3 , model(orr) kr(0.5) mfx(lin) lmcol diag Hasil fitting model dengan Ordinary Ridge Regression: ==================================================== * (OLS) Ridge Regression - Ordinary Ridge Regression ==================================================== y = x1 + x2 + x3 -----------------------------------------------------------------Ridge k Value = 0.50000 | Ordinary Ridge Regression -----------------------------------------------------------------Sample Size = 20 Wald Test = 97.9066 | P-Value > Chi2(3) = 0.0000 F-Test = 32.6355 | P-Value > F(3 , 16) = 0.0000 (Buse 1973) R2 = 0.8968 | Raw Moments R2 = 0.9936 (Buse 1973) R2 Adj = 0.8775 | Raw Moments R2 Adj = 0.9924 Root MSE (Sigma) = 6.6848 | Log Likelihood Function = -64.1440 ------------------------------------------------------------------ R2h= 0.9247 R2h Adj= 0.9106 F-Test = 65.53 P-Value > F(3,16) 0.0000 - R2v= 0.6313 R2v Adj= 0.5622 F-Test = 9.13 P-Value > F(3,16) 0.0009 101 ------------------------------------------------------------y | Coef. Std. Err. t P>|t| [95% Conf. Interval] ------+-----------------------------------------------------x1 | .4519515 .2563028 1.76 0.097 -.0913863 .9952892 x2 | 1.483555 .9682758 1.53 0.145 -.5690985 3.536208 x3 | 2.25139 1.605101 1.40 0.180 -1.151273 5.654053 _cons | 10.48659 13.1727 0.80 0.438 -17.43829 38.41146 ------------------------------------------------------------Beberapa nilai kriteria diagnostik untuk model yang digunakan: ================================================================== * OLS Model Selection Diagnostic Criteria - Model= (orr) ================================================================== - Log Likelihood Function LLF = -64.1440 -------------------------------------------------------------------- Akaike Information Criterion (1974) AIC = 53.3313 - Akaike Information Criterion (1973) Log AIC = 3.9765 -------------------------------------------------------------------- Schwarz Criterion (1978) SC = 65.0834 - Schwarz Criterion (1978) Log SC = 4.1757 -------------------------------------------------------------------- Amemiya Prediction Criterion (1969) FPE = 53.6235 - Hannan-Quinn Criterion (1979) HQ = 55.4454 - Rice Criterion (1984) Rice = 59.5817 - Shibata Criterion (1981) Shibata = 50.0486 - Craven-Wahba Generalized Cross Validation (1979) GCV = 55.8578 -------------------------------------------------------------------Beberapa hasil uji diagnostik multikolinearitas: 102 ===================================================== *** Multicollinearity Diagnostic Tests - Model= (orr) ===================================================== * Correlation Matrix (obs=20) | x1 x2 x3 ----------+--------------------------x1 | 1.0000 x2 | 0.7185 1.0000 x3 | 0.9152 0.6306 1.0000 * Multicollinearity Diagnostic Criteria +-----------------------------------------------------------------+ | Var | Eigenval | C_Number | C_Index | VIF | 1/VIF | R2_xi,X | |-----+----------+----------+---------+--------+--------+---------| | x1 | 2.5160 | 1.0000 | 1.0000 | 7.7349 | 0.1293 | 0.8707 | | x2 | 0.4081 | 6.1651 | 2.4830 | 2.0862 | 0.4793 | 0.5207 | | x3 | 0.0758 | 33.1767 | 5.7599 | 6.2127 | 0.1610 | 0.8390 | +-----------------------------------------------------------------+ * Farrar-Glauber Multicollinearity Tests Ho: No Multicollinearity - Ha: Multicollinearity -------------------------------------------------* (1) Farrar-Glauber Multicollinearity Chi2-Test: Chi2 Test = 43.8210 P-Value > Chi2(3) 0.0000 * (2) Farrar-Glauber Multicollinearity F-Test: +------------------------------------------------------+ | Variable | F_Test | DF1 | DF2 | P_Value | |-----------+----------+----------+---------+----------| | x1 | 57.246 | 17.000 | 3.000 | 0.003 | | x2 | 9.233 | 17.000 | 3.000 | 0.046 | | x3 | 44.308 | 17.000 | 3.000 | 0.005 | +------------------------------------------------------+ 103 * (3) Farrar-Glauber Multicollinearity t-Test: +-------------------------------------+ | Variable | x1 | x2 | x3 | |----------+--------+--------+--------| | x1 | . | | | | x2 | 4.259 | . | | | x3 | 9.362 | 3.350 | . | +-------------------------------------+ * |X'X| Determinant: |X'X| = 0 Multicollinearity - |X'X| = 1 No Multicollinearity |X'X| Determinant: (0 < 0.0779 < 1) -----------------------------------------------------* Theil R2 Multicollinearity Effect: R2 = 0 No Multicollinearity - R2 = 1 Multicollinearity - Theil R2: (0 < 0.9529 < 1) -------------------------------------------------------* Multicollinearity Range: Q = 0 No Multicollinearity - Q = 1 Multicollinearity - Gleason-Staelin Q0: (0 < 0.7641 < 1) 1- Heo Range Q1: (0 < 0.8581 < 1) 2- Heo Range Q2: (0 < 0.8129 < 1) 3- Heo Range Q3: (0 < 0.7209 < 1) 4- Heo Range Q4: (0 < 0.7681 < 1) 5- Heo Range Q5: (0 < 0.8798 < 1) 6- Heo Range Q6: (0 < 0.7435 < 1) ----------------------------------------------- 104 * Marginal Effect - Elasticity (Model= orr): Linear * +---------------------------------------------------------------+ | Variable | Marginal_Effect(B) | Elasticity(Es) | Mean | |----------+--------------------+------------------+------------| | x1 | 0.4520 | 0.3280 | 52.5840 | | x2 | 1.4836 | 0.3629 | 17.7245 | | x3 | 2.2514 | 0.1645 | 5.2935 | +---------------------------------------------------------------+ Mean of Dependent Variable = 72.4650 Perbandingan hasil fitting model dengan regresi OLS dan regresi ridge diperlihatkan sebagai berikut: regresi ols 107.37 0.0000 regresi ridge 32.635 0.0000 Coef. x1 x2 x3 _cons 1.059 0.452 0.121 8.133 0.452 1.484 2.251 10.487 Std. Err. x1 x2 x3 _cons 0.174 0.656 1.087 8.921 0.256 0.968 1.605 13.173 P>|t| x1 x2 x3 _cons 0.000 0.500 0.913 0.375 0.097 0.145 0.180 0.438 F (3, 16) Prob > F Tampak hasil yang cukup berbeda antara regresi OLS dengan regresi ridge. 105 KEPUSTAKAAN Baddeley MC & Barrowclough DV. 2009. Running Regressions: A Practical Guide to Quantitative Research in Economics, Finance and Development Studies. Cambridge University Press, Cambridge. Bingham NH & Fry JM. 2010. Regression: Linear Models in Statistics. Springer, London. Chatterjee S & Hadi AS. 2012. Regression Analysis by Example, 5th Ed. John Wiley & Sons, Hoboken, New Jersey. Cook RD & Weisberg S. Residuals and Influence in Regression. 1982. Chapman and Hall, New York. Fahrmeir L, Kneib T, Lang S, & Marx B. 2013. Regression: Models, Methods and Applications. Springer, New York. Gordon RA. 2015. Regression Analysis for the Social Sciences, 2nd Ed. Routledge, New York. Keith TZ. 2015. Multiple Regression and Beyond: An Introduction to Multiple Regression and Structural Equation Modeling, 2nd Ed. Routledge, New York. LaMorte WW. 2018. The Power of Multiple Regression Models. Boston University School of Public Health. Available from <http://sphweb. bumc.bu.edu/otlt/MPH-Modules/QuantCore/PH717_MultipleVariable Regression/index.html> Mendelhall W & Sincich T. 2012. A Second Course in Statistics: Regression Analysis, 7th Ed. Prentice Hall, Boston. Montgomery DC, Peck EA, & Vining GG. 2012. Introduction to Linear Regression Analysis, 5th Ed. John Wiley & Sons, Hoboken, New Jersey. Pardoe I. 2012. Applied Regression Modeling, 2th Ed. John Wiley & Sons, Hoboken, New Jersey. Richardson S. 2015. Business Applications of Multiple Regression, 2nd Ed. Business Expert Press, New York. Vach W. 2013. Regression Models as A Tool in Medical Research. CRC Press, Boca Raton, FL. 106 Vittinghoff E, Glidden DV, Shiboski SC, & McCulloch CE. 2012. Regression Methods in Biostatistics: Linear, Logistic, Survival, and Repeated Measures Models, 2nd Ed. Springer, New York. Weisberg S. Applied Linear Regression, 4th Ed. 2014. John Wiley & Sons, Hoboken, New Jersey. Xin Y & Xiao GS. 2009. Linear Regression Analysis: Theory and Computing. World Scientific Publishing, Singapore. 107 Lampiran 1 PEMODELAN DAN SELEKSI PREDIKTOR Tujuan pemodelan adalah mendapatkan model dengan fitting terbaik dan paling parsimoni (hemat prediktor), namun juga secara masuk akal (reasonably) mampu menjelaskan hubungan substantif antara himpunan prediktor dengan respons sesuai dengan ranah bidang ilmu yang bersangkutan. Tiap penambahan prediktor baru ke dalam model akan memperbesar koefisien determinasi R 2 yang merupakan proporsi variansi respons yang ‘dijelaskan’ oleh himpunan prediktor, tetapi juga semakin menjauhkan model dari prinsip parsimoni. Dengan demikian jika jumlah ‘kandidat’ prediktor relatif besar, diperlukan prosedur seleksi variabel independen untuk pemodelan. Prosedur seleksi variabel dibedakan menjadi: 1. Seluruh kemungkinan regresi (all possible regressions): Dilakukan pemodelan dengan tiap kemungkinan kombinasi variabel independen, lalu dari seluruh model tersebut dipilih 1 model yang terbaik. Prosedur ini hanya dapat dikerjakan jika jumlah ‘kandidat’ prediktor tidak terlalu besar. Jika dimiliki k ‘kandidat’ prediktor, maka jumlah model regresi yang mungkin dibuat adalah 2k − 1 . Misalkan dimiliki 10 ‘kandidat’ prediktor, maka jumlah model yang harus diperiksa adalah 210 − 1 = 1023 model. Harus bahwa penilaian model tidak hanya mencakup aspek statistiknya, tetapi juga aspek substantif ranah bidang ilmu yang bersangkutan 2. Prosedur stepwise: Prosedur stepwise dapat dilaksanakan dengan 2 cara, yaitu seleksi ke depan atau eliminasi ke belakang. 108 a. Seleksi ke depan (forward selection) Mula-mula dilakukan regresi linear sederhana dengan masingmasing prediktor, lalu dipilih 1 model dengan prediktor yang nilai p-nya terkecil. Seleksi ke depan dimulai dengan menambahkan prediktor kedua yang nilai p-nya terkecil kedua di antara himpunan regresi linear sederhana mula-mula. Jika nilai p-nya menunjukkan prediktor baru ini bermakna, seleksi dilanjutkan dengan menambahkan prediktor yang nilai p-nya terkecil ketiga, dan seterusnya. Prosedur dilaksanakan sampai prediktor yang terakhir dimasukkan tak bermakna (nilai p-nya lebih besar daripada 0.05), maka yang dipilih adalah model yang terakhir yang tiap prediktornya masih bermakna. b. Eliminasi ke belakang (backward elimination) Seleksi dimulai dengan regresi linear ganda yang menginklusikan semua ‘kandidat’ prediktor. Dipilih prediktor yang nilai p-nya terbesar dan lebih besar daripada 0.05 untuk dieliminasi dari model. Jika pada fitting ulangan masih ada prediktor dengan nilai p lebih besar daripada 0.05, seleksi dilanjutkan dengan mengeliminasikan prediktor dengan nilai p terbesar, dan seterusnya. Seleksi berakhir apabila seluruh prediktor sisa masing-masing memiliki nilai p lebih kecil daripada 0.05. Perhatikan: - Pemodelan tidak boleh dilakukan dengan meregresikan respons terhadap himpunan seluruh ‘kandidat’ prediktor, lalu sekaligus mengeliminasikan semua prediktor yang nilai p-nya lebih besar daripada 0.05. Eliminasi tidak boleh dilakukan secara bersamaan sekaligus, karena dalam model dengan beberapa prediktor yang tak bermakna demikian, eliminasi 1 prediktor saja dengan nilai p terbesar adakalanya mengakibatkan seluruh prediktor tersisa menjadi bermakna. - Seluruh prosedur di atas dilaksanakan dengan asumsi batas ‘kemaknaan’ adalah 0.05. Asumsi demikian dibutuhkan sebagai dasar untuk pelaksanaan langkah-langkah seleksi. Dalam kenyataannya besar batas 109 ‘kemaknaan’ demikian dapat saja diubah menurut pertimbangan peneliti. Selain itu aspek substantif adakala lebih perlu diperhatikan daripada aspek statistik. Variabel yang menurut peneliti sangat penting dapat saja tetap dipertahankan dalam model, walaupun nilai p-nya melebihi 0.05. - Pada tahap akhir, perlu diperhatikan pula pemenuhan asumsi nonmultikolinearitas. Pasangan prediktor yang merupakan pasangan kolinearitas adakalanya perlu dikeluarkan salah satu di antaranya dari model. 110 Lampiran 2 BEBERAPA GRAFIK GALAT Dalam regresi linear, terdapat sejumlah grafik galat, yang terutama digunakan dalam diagnostika regresi. Dalam Stata kumpulan grafik galat tersebut dikenal sebagai residual plots, yang hanya dapat ditampilkan setelah perintah regress, dan karena itu dikelompokkan sebagai regress postestimation plots. Beberapa grafik galat yang akan diperlihatkan di sini adalah: - rvfplot - acprplot - avplot - rvpplot - avplots - lvr2plot - cprplot Contoh: . use “D:\Data\elemapi” . regress api00 acs_k3 meals full Source | SS df MS ---------+---------------------------Model | 2634884.26 3 878294.754 Residual | 1271713.21 309 4115.57673 ---------+---------------------------Total | 3906597.47 312 12521.1457 Number of obs F( 3, 309) Prob > F R-squared Adj R-squared Root MSE = = = = = = 313 213.41 0.0000 0.6745 0.6713 64.153 -------------------------------------------------------------------api00 | Coef. Std. Err. t P>|t| [95% Conf. Interval] -------+-----------------------------------------------------------acs_k3 | -2.681508 1.393991 -1.92 0.055 -5.424424 .0614073 meals | -3.702419 .1540256 -24.04 0.000 -4.005491 -3.399348 full | .1086104 .090719 1.20 0.232 -.0698947 .2871154 _cons | 906.7392 28.26505 32.08 0.000 851.1228 962.3555 111 -------------------------------------------------------------------- -200 -100 Residuals 0 100 200 . rvfplot Grafik rvfplot (residual versus fitted plot) adalah plot galat vs nilai prediksi respons. Grafik ini terutama bermanfaat untuk mendeteksi data pencilan (outlier), yang memiliki nilai galat besar. - Sumbu Y: Galat (residuals) = ei - Sumbu X: Prediksi respons (fitted values) = Yˆi . avplot meals Grafik avplot (added variable plot) adalah grafik untuk menunjukkan hubungan antara respons dengan satu variabel independen yang dispesifikasikan, dengan penyesuaian (adjusted for) terhadap variabel independen lainnya. Kemiringan (slope) grafik ini menyatakan koefisien regresi parsial variabel independen yang dispesifikasikan tersebut. Pengamatan dengan leverage yang tinggi akan tampak sebagai titik yang berjarak horizontal jauh dari sisa datanya. Sintaks untuk menampilkan grafik avplot adalah: 112 -200 0 e( api00 | X ) 200 400 avplot indepvar Misalkan: Yi = b 0 + b1 X1i + ei dan X 2i = v 0 + v1 X1i + fi maka: - Sumbu Y: Galat regresi respons terhadap (himpunan) variabel independen minus variabel independen yang dispesifikasikan = ei - Sumbu X: Galat regresi variabel independen yang dispesifikasikan terhadap (himpunan) variabel independen sisa = fi . avplots Perintah avplots menghasilkan grafik avplot untuk seluruh variabel independen dalam satu citra. 113 400 200 -200 e( api00 | X ) 0 200 e( api00 | X ) -200 -100 0 100 200 e( api00 | X ) -200 -100 0 100 . cprplot acs_ k3 Grafik cprplot (component-plus-residual plot) adalah grafik galat plus komponen vs variabel independen yang dispesifikasikan. Sintaksnya adalah: cprplot indepvar 114 100 Component plus residual -200 -100 0 -300 Misalkan: Yi = b 0 + b1 X1i + b 2 X 2i + ei - Sumbu Y: Galat galat plus komponen = ei + b1 X1i - Sumbu Y: Variabel independen yang dispesifikasikan = X1i . acprplot full Grafik acprplot adalah grafik galat parsial tertambah (augmented component-plus-residual plot) untuk variabel independen tertentu. Sintaksnya adalah: acprplot indepvar 115 200 Augmented component plus residual -100 0 100 -200 Grafik ini merupakan pengembangan dari cprplot dengan menambahkan komponen kuadrat prediktor. Opsi lowess digunakan untuk mendeteksi adanya penyimpangan dari asumsi linearitas. -200 Augmented component plus residual -100 0 100 200 . acprplot full, lowess 116 . rvpplot meals Grafik rvpplot (residual versus predictor) adalah grafik galat vs prediktor, mem-plot galat terhadap prediktor spesifik. Sintaksnya adalah: -200 -100 Residuals 0 100 200 rvpplot indepvar - Sumbu Y: Galat - Sumbu X: Variabel independen yang dispesifikasikan . lvr2plot Grafik lvr2plot (leverage versus squared residual) adalah grafik leverage vs galat terstandardisasi kuadrat. Nilai galat terstandardisasi kuadrat yang besar mengindikasikan respons memiliki nilai yang jauh berbeda dari yang diprediksikan oleh model. Nilai ekstrim pada sumbu X ataupun kombinasi nilai yang sangat berbeda pada sumbu X dan Y menunjukkan pengamatan dengan leverage yang tinggi. Sintaks untuk menampilkan lvr2plot adalah: lvr2plot 117 .8 .6 Leverage .4 .2 0 - Sumbu Y: Leverage Sumbu X: Galat terstandarsisasi kuadrat 118