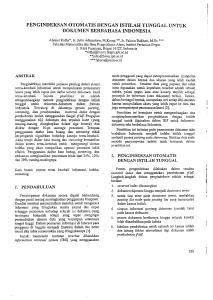

Evaluasi algoritme breadth first, best first, dan page

advertisement

PENDAHULUAN Latar Belakang Sekitar tahun 1990-an hasil penelitian menunjukkan bahwa orang lebih banyak mencari dan mendapatkan informasi melalui media cetak atau media lain, bukan dari sistem temu kambali informasi. Dalam satu dekade terakhir, optimasi dan efektivitas sistem temu kembali informasi mencapai kualitas yang lebih baik, sehingga membuat sebagian besar pengguna internet lebih percaya mencari dan mendapatkan informasi, menggunakan sistem temu kembali informasi. Tahun 2004 survey Pew Internet (Follow 2004, diacu dalam Manning et al. 2009) menunjukkan bahwa 92% pengguna internet menyatakan internet merupakan tempat yang baik untuk mencari dan mendapatkan informasi. Jumlah halaman web pada akhir Januari 2005 diperkirakan mencapai 11,5 miliar halaman (Romero 2006), dengan jumlah halaman web yang sangat banyak, maka dapat digunakan oleh sistem pencarian web untuk menemukembalikan informasi sesuai dengan keinginan pengguna. Google yang merupakan mesin pencari terbesar saat ini diperkirakan telah melakukan pengindeksan halaman web mencapai delapan miliar. Salah satu strategi untuk mengumpulkan halaman web yang tersebar di internet pada domain berbeda, dan disesuaikan dengan kata kunci yang diinginkan oleh pengguna yaitu dengan membangun pengindeksaan halaman web. Sejak akhir tahun 1990, banyak penelitian yang membahas tentang strategi pengumpulan halaman web, strategi yang paling populer adalah web crawling. Pada tahun 2006, Rafael Romero Trujillo (Department of Information Technology Lund University, Swedia) melakukan penelitian tentang web crawling yang berjudul Simulation Tool to Study Focused Web Crawling Strategies. Hasil penelitian ini menunjukkan nilai precision terhadap 100.000 dokumen yang dikumpulkan, untuk algoritme breadth first, best first, page rank, dan breadth first with time constraint yaitu masing-masing 28,797%, 33,930%, 35,090%, dan 37,691%. Web crawling adalah suatu proses untuk mengumpulkan halaman web, kemudian dilakukan pengindeksan halaman web yang bertujuan untuk mendukung sistem pencarian web. Aplikasi untuk web crawling biasa disebut dengan web crawler. Tujuan Tujuan penelitian ini adalah mengimplementasikan beberapa algoritme web crawling. Kemudian melakukan evaluasi terhadap beberapa algoritme web crawling tersebut. Ruang Lingkup Ruang lingkup penelitian ini yaitu : 1. Web crawler yang dibangun hanya menjelajahi format standar halaman web, dan tidak menjelajahi : a. file dengan ekstensi .jpg, .png, .gif, .swf, .doc, .docx, .ppt, .pptx, .xls, xlsx, .pdf, .zip, .tar, .gz, dan .tar.gz. b. sebuah halaman web yang menerapkan Robot Exclusion Protocol, yaitu protocol yang menyediakan mekanisme untuk mengatur akses terhadap file. Protocol ini menyebabkan file tidak bisa diambil oleh web crawler. 2. Web crawler yang dibangun dikhususkan untuk dokumen web berbahasa Indonesia. 3. Web crawler yang dibangun tidak melakukan proses stemming terhadap kata atau frase yang didapatkan. Manfaat Manfaat dari penelitian ini yaitu : 1. Web crawler yang dibangun mampu mengumpulkan halaman web dan melakukan pengindeksan halaman web. 2. Mampu melakukan evaluasi terhadap beberapa algoritme web crawling. 3. Hasil pengindeksan halaman web dapat digunakan untuk membangun sistem temu kembali informasi, atau dapat juga digunakan untuk penelitian lain di bidang temu kembali informasi maupun di bidang lainnya. 1